自2023年开始,全球范围掀起了以大规模人工智能模型为代表的生成式人工智能浪潮。过去一年,与计算能力、算法、数据、网络安全、云计算和人工智能相关的企业和领域,都在人工智能大模型领域受到了极大的关注。然而,从技术革新的角度来看,国内生产和生活方式并没有因为国产大模型而发生质的改变。

前不久,李开复在一场采访中直言不讳地指出,对于美国人来说,“ChatGPT时刻”发生在17个月前,但中国用户却还在渴望拥有属于自己的“AI时刻”。

总的来说,国内的聊天机器人和工具的发展还不够出色。李开复明确表示,“中国必须自主研发出自己的ChatGPT,以激发公众对人工智能技术的浓厚兴趣,并推动其在更多领域的应用和投资。”

与此同时,越来越多的专家和学者纷纷呼吁:“没有实际应用的大型模型是毫无意义的。”

比如李彦宏就公开表示,中国现在数百个基础模型是对社会资源巨大的浪费,更多的资源应该如何探索与各行各业的结合,以及下一个超级应用的可能性。

在需求端,市场其实非常迫切想要找到能快速落地、产生效益的人工智能产品和服务。对于大规模模型开发者和应用者来说,卷积参数已经没有任何意义。在火山引擎总裁谭待看来,“如何让更多人、各行各业用起来”,才是现阶段对于“好模型”的最佳定义。

许多行业专家预测,今年将是中国生成式人工智能应用迅速发展的一年。而目前市场上的关键突破口是“价格”,这已经成为行业的共识。

使用方法的关键

在刚刚结束的春季功能更新会上,OpenAI宣布了其最新模型GPT-4o,不仅性能有显著提升,价格也下调了一半。要知道,这是自2023年初以来,OpenAI进行的第4次降价。

在当前市场上,大模型通常是以1000 tokens为计费单元。以GPT4为例,从去年3月发布至今,OpenAI把GPT4升级到GPT-4o,输入价格从0.03美元/1000 tokens下降到0.005美元/1000 tokens,降幅高达83%;输出价格也从0.06美元/1000 tokens下降到0.015美元/1000 tokens,降幅为75%。

根据OpenAI的预期,他们的大型模型的成本将每年以50-75%的速度继续下降。

除了OpenAI之外,还有其他将成本降低并融入业务发展主线的公司。今年以来,为了加快应用端的推广,国内的大型模型开发者不仅开始跟随降价的趋势,甚至降价幅度达到了令人惊讶的程度。

例如智谱大模型在本月官宣其新的价格体系,入门级产品 GLM-3 Turbo 模型调用价格从 5 元/百万 tokens 降至 1 元/百万 tokens,降幅高达 80%。

再比如DeepSeek在5 月 6 日发布的二代 MoE 大模型DeepSeek-V2,能力对标GPT-4、llama 3-70B,每百万 tokens 的输入和输出分别是 1 元和2 元,只有 GPT-4 Turbo 价格的近百分之一。

再举一个例子,DeepSeek 在5 月 6 日发布了第二代 MoE 大模型 DeepSeek-V2。它的能力可以与GPT-4、llama 3-70B相媲美。每百万个 tokens 的输入和输出分别只需 1 元和2 元,仅相当于 GPT-4 Turbo 价格的近百分之一。

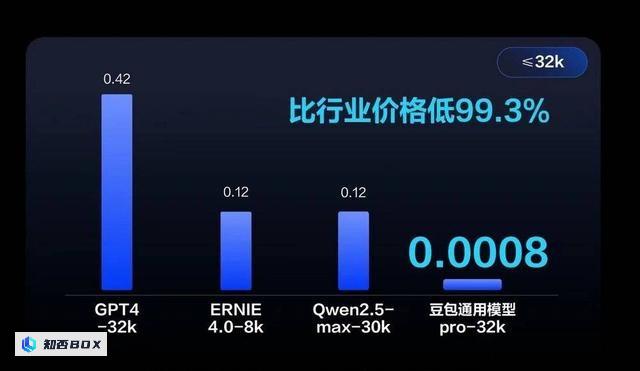

而字节在5月15日发布的豆包大模型,直接把AI使用成本从“以分为单位”,干到了“以厘为单位”的时代。

而字节在5月15日发布的豆包大模型,成功地将人工智能的使用成本从以每分钟为单位降低到以每千分之一厘为单位的时代。其中,主力模型豆包Pro 32k定价0.8厘/1000 tokens,比行业平均价格降低99.3%。在全行业降价的背景下,同样是1块钱,用户可以从GPT买到2400个 token,而国产大模型可以得到8000多个 token。

如果用户使用开源Llama模型自己搭建,大概能够获得30000个token。而1块钱,在豆包大模型上可以获得1250000个token,相当于处理3本75万字的《三国演义》的文字量。

在过去一年上演的“百模大战”,每隔一段时间总会有人对“如何加速模型落地”进行追问。毫无疑问,AI大模型具有巨大的潜在价值,等待市场参与者去挖掘,但目前只是行业非常早期的探索阶段。

人工智能(AI)作为一场以降低成本为驱动力的生产力革命,其大型模型的价值在于通过创建图像和语言理解,使得创造的边际成本趋近于零。在火山引擎总裁谭待看来,降价是推动价值创造的重要动力:“目前在面向企业市场的大型模型应用场景还很有限,包括OpenAI也在不断降价,我们的共同目标是扩大市场规模。”只有降低客户试错成本,才能促进产业繁荣。

一位行业人士坦言,目前中国人工智能(AI)大模型应用的市场规模,与所有市场玩家投入的训练成本相比微不足道。企业还无法通过面向企业(to B)服务实现正循环,其收入差距超过了两个数量级。在这种情况下,大模型企业试图通过降价,让更多人使用,这至少是一种可以尝试的方法。

低价而非价格战

中国企业一直以来都坚持应用主义的原则,大多数企业之所以愿意 embrace AI 时代,就是希望通过利用 AI 来创造差异化优势,从而提高行业竞争力。

然而,面对市场上不断涌现的各种大型模型,用户很难准确地选择适合自己的模型。再加上企业缺乏对模型进行调优和专业数据处理的经验,导致实际应用效果与预期不符,很难与企业自身的业务相匹配。

模型效果是AI落地最关键的一环。多位行业从业者表示,好的技术一定是在大规模应用,不断打磨的情况下形成的。这与字节在豆包大模型发布会上对外阐述的理念一致——用起来才是关键。“只有在真实场景中广泛应用,被更多人使用,调用量越大,才能让模型的性能不断提升。”谭待告诉虎嗅。

通常来说,价格是用户对于大型模型的首要考虑因素。毕竟人工智能创新的风险系数非常高,很多企业即使想做各种创新,可受限于模型使用成本,并且担心模型难以胜任各个行业的任务,导致投资回报率为负,因此会更倾向尝试没有门槛负担的工具。

谭待粗略算了一笔账,企业要想用AI做一项创新,至少要消耗100亿 token,如果按照大模型之前的售价,平均需要花费80万元,而现在使用豆包大模型,只需要8000元就能搞定。

谭待粗略算了一笔账,企业要想用AI做一项创新,至少要消耗100亿 token,如果按照大模型之前的售价,平均需要花费80万元,而现在使用豆包大模型,只需要8000元就能搞定。根据谭待的估算,使用AI进行创新至少需要100亿 token。以前大模型的售价平均为80万元,而现在使用豆包大模型只需要8000元即可完成。过去,大模型推理成本下降,很大程度上依赖于算力的升级。而豆包之所以在价格上“碾压”其他同类大模型,依靠的是模型结构的优化、工程上从传统的单机推理变为分布式推理,以及将不同负载的推理进行混合调度等方式,从而带来超出预期的降本效果,也成为打开AI应用的重要“开关”。

值得注意的是,包括百度、阿里巴巴、腾讯、京东等头部大厂,也都在把大模型的竞争焦点放在了模型训练效率提升,降低大模型的推理成本上。

当然,如果只是简单地比较价格,任何人都可以提供更低价格的大型模型。但是,如果我们真的想要突破大型模型与行业之间的障碍,让美好的场景更加普遍发生,我们需要更低的成本,但不能以牺牲模型质量为代价。

例如市面上也有很多轻量化模型,虽然也做到了比较低的成本,但是以压缩了模型能力和推理成本为代价,在效果上大打折扣,不能与其主力模型相提并论。

例如市面上也有很多轻量化模型,虽然也做到了比较低的成本,但是以减少了模型的能力和推理成本为代价,在效果上大打折扣,无法与其主力模型相媲美。尽管大型模型降价的趋势已经变得不可避免,但字节公司宣称的“行业最低价”也引起了广泛的讨论。

一方认为,豆包大模型以行业最低价让企业用最低成本就能调用大模型,加速了应用落地;另一方则批评,字节的野心让其过早地触发了价格战,随着各家大模型使用成本逐步降低,接下来很可能会上演一场市场争夺战。

对于外界的质疑,谭待解释称,大模型现在还是初期阶段,远没有到激烈竞争的程度,模型的推理成本未来一定会继续下降,“或许,等到那时再回看今天的0.8厘钱,也许一点都不便宜。相比之下,我们只不过是提前那么一步而已,目的并非是为了驱赶对手。”

况且,低价并不意味着进行“价格战”。对于B端市场来说,保持长期盈利是非常重要的。谭待表示:“不亏损是保障业务稳定的关键,也是火山引擎的原则。”因为只有这样,才能长期可持续地提供服务。

从概念验证迈向实际应用

在去年人工智能大爆发引发的大规模模型训练热潮中,包括智谱AI、月之暗面、Minimax、零一万物最早都使用了火山引擎的强大计算能力来进行模型训练。

谭待坦言,云市场的竞争主要集中在规模上。AI大模型的受欢迎程度为云厂商提供了新的市场机遇。微软Azure是最好的例证。通过与OpenAI的合作,微软Azure的云业务取得了巨大成功,成为全球领先的智能云服务提供商。

目前,豆包大模型已经在火山引擎上正式开始对外提供服务。根据官方数据,豆包大模型每天使用的Tokens数量达到了1200亿,每天生成的图片数量超过了3000万张。

去年,当大多数公司在上演“百模大战”时,字节公司的“缺席”曾一度被外界认为存在严重的滞后性。彼时的豆包大模型,还处于初期发展阶段。然而,意想不到的是,经过一段时间的沉默,字节公司在这个关键时刻终于出手。

除了模型的效果和成本,应用落地也非常关键。在过去一年里,豆包接入了包括抖音、头条、番茄小说等50多个业务,业务场景涵盖办公智能助手、电商导购、售后客服、营销创作、数据智能分析、编程助手等,并邀请了手机、汽车、金融、消费、互娱领域的行业头部客户内测。

在模型打磨的过程中,挑战一直都在。首先要确保基础能力和性能达到相应的标准,然后需要与企业客户进行对接,解决许多问题。例如,需要搭建大型模型评估和应用流程,包括测试集合、案例分析和精细调整能力等。否则很难确定哪些场景是可靠的,哪些场景在短期内不适合。

在与企业客户合作的过程中,火山引擎团队逐渐深入了解和适应助手类、知识类、娱乐类、教育类等不同场景,并在火山方舟2.0平台上为这些场景植入了相应的插件和工具平台,通过不断实践和摸索,找到了最佳的解决方案。

大模型的能力目前在多个方面令人惊叹,但也存在许多缺陷。与此同时,大模型也在快速演进,每隔三个月或半年都会发生重大变化。这正是开发大模型产品所面临的挑战和乐趣之处,需要在这种持续动态的技术发展中,不断判断下一个产品的PMF(产品市场匹配点)可能是什么。

值得一提的是,在字节的AI 应用搭建平台“扣子”上,已经有一些开发者通过他们自己开发的应用,成功实现了每月收入达到百万的目标。谭待预测在今年下半年,大模型在应用方面将会让更多场景,从概念验证阶段走向落地阶段。

目前,火山引擎已经与招商银行、蒙牛、OPPO等企业用户展开了合作和探索,共同应用于核心业务场景。对于大模型的未来发展,需要时间来验证。