随着大模型的热潮,GPU也迅速走红。如今,GPU的使用量几乎成为评估大模型成功与否的重要指标。

图形处理器(GPU)在大模型中发挥着重要作用,但并不是唯一的关键因素。与GPU相比,中央处理器芯片(CPU)诞生更早,它在大模型中的地位可能被低估了。

尤其是在端侧大模型兴起之后,端侧推理越来越成为中央处理器(CPU)的主要应用领域。

在过去的六个月里,端侧推理已经成为继“百模大战”之后的下一个行业趋势。这一趋势催生了AI PC、AI手机等概念,这些概念也成为了电脑厂商和手机厂商争夺的重要领域。

将大型模型嵌入到个人电脑、手机或其他硬件设备中,需要具备足够的计算能力来支持,同时还需要考虑效率和功耗的平衡。而在当前阶段,CPU很可能是最优的端侧推理算力解决方案。

1.端侧大模型引起了广泛关注

今天,如果你想体验业内最领先的大模型对话助手,无论是OpenAI的ChatGPT,还是国内的Kimi、智谱清言等,都必须要联网。这些大模型都部署在云端,适合编排涉及高级推理、数据分析和上下文理解的复杂任务的应用程序。

今天,如果你想体验业内最领先的大型对话助手,无论是OpenAI的ChatGPT,还是国内的Kimi、智谱清言等,都需要连接到互联网。这些大型模型都部署在云端,适用于处理复杂任务,包括高级推理、数据分析和上下文理解的应用程序。然而,云端模型不仅需要大量的计算资源成本,还需要用户上传数据。考虑到成本和数据隐私安全等因素,将大型模型部署在终端设备上已经成为一种趋势。

在大规模应用于终端设备的需求下,我们可以观察到业界正在出现的两个趋势:

第一个趋势是大模型正在变得越来越小。

Meta、谷歌、微软等大厂在发布大模型时,往往是一个“中杯、大杯、超大杯”的模型家族,其最小的模型参数基本都在10B以下,并且有的会专门为手机等大众级终端设备进行适配。

比如,微软在去年专门成立了一个小模型(SLM)团队,并在今年5月22日的微软Build开发者大会上发布了专门为手机端侧推理而设计的Phi-3系列模型;随后,在6月11日的WWDC开发者大会上,苹果也低调发布了一个3B的端侧小模型。

比如,微软在去年专门成立了一个小模型(SLM)团队,并在今年5月22日的微软Build开发者大会上发布了专门为手机端侧推理而设计的Phi-3系列模型;随后,在6月11日的WWDC开发者大会上,苹果也低调发布了一个3B的端侧小模型。这些小模型的出现,为手机端的推理任务提供了更高效和更快速的解决方案。值得一提的是,小模型并非要取代大模型,而是更适合处理那些不需要大量复杂推理或快速响应的应用程序。

随着适合在终端设备上进行推理的小型模型不断涌现,第二个趋势迅速出现——终端厂商正在积极尝试将这些模型嵌入到个人电脑、手机等设备中,这就是目前热议的“AI PC”、“AI手机”等概念。

上个月,苹果和微软相继发布了最新的个人电脑设备,引发了人们对AI PC的概念的高度关注。5月8日,苹果在春季发布会上发布了自家研发的M4芯片,该芯片采用了先进的Arm架构,并且其内置的神经网络引擎性能非常强大,足以傲视当前的AI PC技术水平。而在两周后,微软推出了一款名为“Copilot+PC”的全新“AI PC新物种”,该设备搭载了基于Arm架构的高通处理器。

摩根士丹利在5月14日发布的研报中指出,预计到2025年-2026年,人工智能个人电脑(AI PC)的普及率将从2024年的8%增长至50%。

在人工智能手机领域,vivo X100系列、OPPO Find X7系列,以及荣耀Magic 6等安卓旗舰产品已经成功实现了70亿大模型的本地部署;联发科最新发布的天玑9300+旗舰芯片能够实现Llama-2-7B端侧大模型更高速的运行。

近期,苹果在WWDC开发者大会上推出了Apple Intelligence,将大语言模型集成到下一代终端设备,让人工智能能力几乎覆盖了所有重要的原生应用,包括相机、照片、备忘录、语音备忘录、提醒事项、邮件、Safari、Keynote等,为用户提供个性化的智能服务。如果说iPhone让手机用户开始抛弃实体键盘,彻底转向大尺寸多点触控屏,那么人工智能加持的iPhone,或许将正式引领全球40亿智能手机用户进入下一轮变革。人工智能手机,有了新的定义。

在新能源汽车、增强现实(XR)等新的终端设备上,大型人工智能(AI)模型也在逐渐应用。例如,小米SU7也引入了端侧AI大型模型,与小爱同学语音助手搭配,为用户带来全新的智能驾驶体验。

可以说,模型公司与终端硬件公司正相向而行,共同推动端侧大模型的应用落地。而两者的交汇点,就是端侧设备的算力条件。在现阶段,中央处理器(CPU)可以认为是端侧推理的算力最优解。

2.跑端侧推理,还得靠中央处理器(CPU)

很多人工智能从业者对于中央处理器(CPU)或多或少带有一些先入为主的“偏见”,认为大型模型的大规模并行计算特点更适合图形处理器(GPU)来处理,但并不适合CPU。

在大规模模型的训练阶段确实如此。但是在大规模模型的推理阶段,特别是在端侧推理时,实际上CPU也能够胜任大部分计算任务。

关于GPU与CPU的关系,可以概括为“专才”与“通才”的对比——GPU像是一名“拥有最强大脑的专才”,其强大的计算能力专门应对图像处理、人工智能计算等需要大规模并行计算与数据吞吐的任务;而CPU像是一名“十八般武艺的通才”,虽然加速计算能力比不上GPU,但擅长处理操作系统、系统软件与应用程序等复杂指令调度、循环、分支、逻辑判断与执行的任务。

既然是一名“通才”,中央处理器(CPU)自然也能够处理人工智能(AI)计算任务。实际上,CPU过去一直在处理这些任务。例如,在智能手机中,有许多功能都需要进行AI计算,包括对面部、手部和身体动作的追踪,高级相机效果和滤镜,以及许多社交应用中的细分功能。这些AI工作负载的处理可以由CPU独立完成,也可以与图形处理器(GPU)或神经网络处理器(NPU)等协处理器一起提供支持。

到了大模型时代,端侧推理出现了新的计算需求,主要的应用场景包括文本生成——虚拟助理可以帮助用户撰写电子邮件;智能回复——即时通讯应用可以自动提供针对某个问题的建议回复;文本摘要——电子书阅读器可以提供章节摘要等。

针对不同的设备和应用场景,计算需求也呈现出差异化。在诸如入门级智能手机、汽车智能座舱、AIoT设备等中低端应用场景中,对计算能力的要求相对较低,中央处理器(CPU)能够高效处理参数规模在数十亿级别的小型计算任务。在一些高端场景,如个人电脑和旗舰智能手机上,所需处理的任务相对更为复杂和庞大,即便配备了人工智能专用加速器,中央处理器仍是不可或缺的算力基石,且能独立承担处理百亿参数级别的更大规模计算任务。以当今的安卓平台来看,第三方应用中有70%的人工智能运行在Arm CPU上。

今天,几乎所有智能手机都采用基于Arm架构的CPU。由于Arm CPU本身具备强大的AI计算能力,全球约99%的智能手机都具备在设备端进行大型模型处理所需的技术。这些技术包括:

NEON扩展架构是一种专门用于加速多媒体和信号处理算法的技术。它可以应用于各种领域,包括视频编码/解码、2D/3D图形处理、游戏渲染、音频和语音处理,以及图像处理等。

SVE(Scalable Vector Extensions)可扩展向量扩展技术是一种能够扩展向量处理能力的技术。它在需要进行大规模数据处理和高性能计算的场景中表现出色,比如在机器学习、数据分析和科学计算等领域。

SVE技术的进阶版SME(Scalable Matrix Extensions)可扩展矩阵扩展技术,是一种能够扩展矩阵计算能力的技术。它通过提升性能和能效,能够满足人工智能、机器学习和高性能计算等领域对计算能力和效率的严苛需求。

根据Arm官方消息显示,预计到2025年底,将有超过1000亿台使用Arm处理器的人工智能设备。

在2024年的世界移动通信大会(MWC 2024)上,Arm展示了在搭载Arm Cortex-A700系列处理器的安卓手机上,使用3个CPU核心运行Llama-2-7B的性能表现。在这个演示中,手机每秒能够生成9.6个单词的文本,这大约是一般成年人平均阅读速度的两倍。这一过程完全在手机本地完成,无需联网。

Arm CPU可在移动设备的边缘侧运行生成式人工智能(AI),图片来自Arm官方网站

一个70亿参数的模型之所以能够在手机端流畅地运行起来,除了Arm CPU本身就具备的AI算力之外,也得益于Arm针对开发者生态做了一系列优化工作,核心是压缩与量化技术。

其中,四位量化技术可以将模型压缩至足够小,以便能在RAM资源有限的设备上流畅运行;高效的线程绑定技术能够轻松提升各类设备的CPU工作负载性能,确保系统的稳定运行;经过深度优化的矩阵乘CPU例程,使得LLM的Token首次生成时间缩短50%以上,文本生成速率提升20%,不仅进一步降低了延时,还为用户带来了更为高效和流畅的使用体验。

AI手机是目前阶段中央处理器(CPU)在移动设备上进行端侧推理的最主要应用场景,但这只是一个起点。随着大型模型的不断发展,越来越多的新模型和应用将会涌现,相信这些新技术将首先在CPU上得到应用。

3.从硬件基础到软件生态的持续迭代

从硬件基础不断发展演进到软件生态的持续迭代过程。在移动互联网时代,Arm计算平台是移动计算的基础设施。如今到了AI时代,Arm计算平台依然保持着持续的升级和创新。

在日前台北电脑展举办前夕,Arm推出了面向智能手机、PC等设备的全新平台型解决方案——Arm终端计算子系统(CSS),结合了最新Armv9架构的特性,其中CPU和GPU在人工智能方面都有大幅性能提升。据Arm介绍,Arm终端CSS是迄今为止运行速度最快的Arm计算平台,在计算和图形性能方面实现了30%以上的提升,同时人工智能推理速度也提高了59%,适用于更广泛的人工智能、机器学习和计算视觉工作负载。

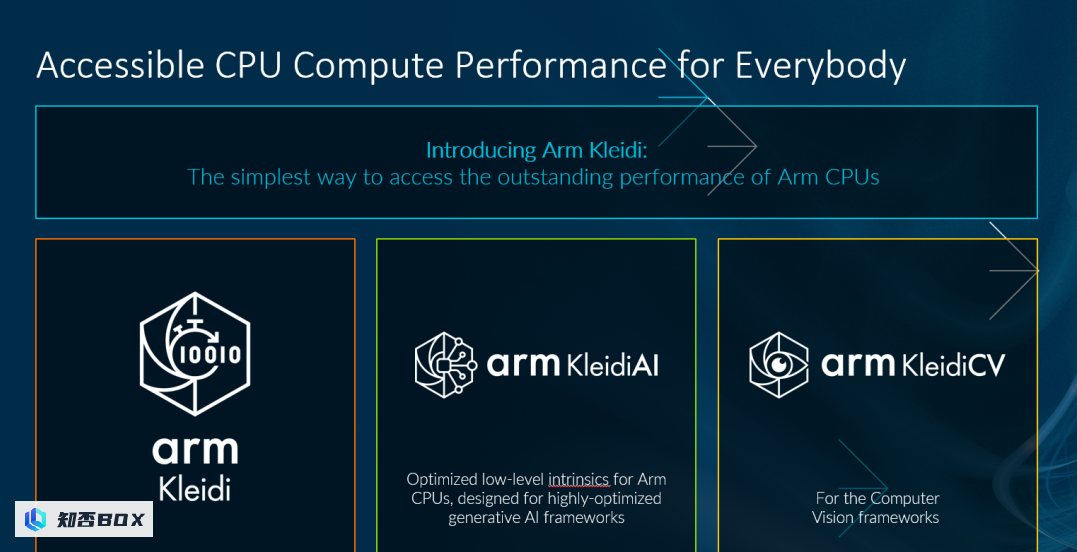

为了帮助开发者快速获取开发生成式人工智能应用所需的性能、工具和软件库,Arm还专门为此定制了Arm Kleidi软件开发平台,其中包括面向生成式人工智能的KleidiAI和针对计算机视觉应用的KleidiCV。KleidiAI支持Arm架构的关键功能,如Neon、SVE2和SME2,并与热门的人工智能框架PyTorch、Tensorflow、MediaPipe等深度集成,可以有效提升Llama-3、Phi-3等关键模型的性能。

可以说,Arm为移动端人工智能的实际应用提供了一个功能齐全的工具集。

全新Arm Kleidi软件开发平台,图片来自Arm官方

Arm CPU以及Arm生态所提供的强大支持能力可广泛适用于各类消费电子设备,包括旗舰智能手机、AI PC,以及主流移动设备、XR和可穿戴设备等在内的各类消费电子设备。虽然不同设备的端侧算力分布参差不齐,但由于CPU的通用性,它能够快速响应端侧大模型的落地需求。

此外,如果想要实现高能效和低功耗的目标,Arm CPU无疑是端侧算力的首选。在主流CPU阵营中,Arm架构以其低功耗特性而著称,这一优势在人工智能个人电脑、人工智能手机等应用场景的能效竞争中尤为关键。

举例来说,在一系列热门手游的运行测试中,当游戏画面以平均每秒120帧的速度运行时,Arm最新发布的终端CSS在相同功耗条件下,可带来37%的平均性能提升,同时GPU功耗降低30%。

由于Arm CPU具有低功耗的特性,因此受到了PC厂商的广泛关注和喜爱。在2020年,苹果公司率先发布了首款采用Arm架构的M1芯片,并将其应用于Mac电脑上,成为了第一批采用这一架构的厂商。如今,苹果的M系列芯片已经迭代到了第四代。

苹果的这一举动让PC厂商意识到,原来Arm CPU不仅能装在手机里,还能装进电脑里,而且性能表现出色。此后,PC厂商逐渐转向Arm CPU阵营。比如,微软近期发布的第一款Copilot+PC,也就是最新的Surface系列,首发搭载的正是高通基于Arm架构的处理器。

随即在人工智能个人电脑(AI PC)概念的基础上,还专门产生了一个更加细分的名词——WoA AI PC,即基于Arm架构的Windows操作系统。

在微软Build大会上,微软特别提到一组数字——现有Arm PC应用程序中,有87%都是原生的Arm版本。除了Microsoft Office、Dropbox、Zoom、Adobe套件,越来越多的主流应用正在成为Arm原生应用。

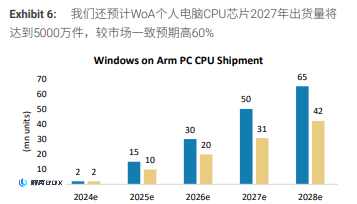

在微软Build大会上,微软特别提到一组数字——现有Arm PC应用程序中,有87%都是原生的Arm版本。除了Microsoft Office、Dropbox、Zoom、Adobe套件,越来越多的主流应用正在成为Arm原生应用。这意味着用户可以更好地利用Arm架构的优势,获得更高的性能和更好的兼容性。随着Arm原生应用的增加,用户将能够在Arm PC上更加流畅地运行各种应用程序,提高工作效率和使用体验。摩根士丹利在最近的研究报告中指出,基于ARM架构的人工智能个人电脑(WoA AI PC)的趋势可能会重新改变全球个人电脑半导体供应链的格局。报告预计,到2027年,WoA AI PC的芯片出货量将达到5000万件,比市场预期高出60%。此外,根据Arm高管的预测,Arm在Windows个人电脑领域的市场份额也在迅速扩大,在未来五年内可能会超过50%。

根据摩根士丹利的数据,Arm CPU在Windows PC市场上的占有率

4.今天不仅是计算的起点,更是计算的支点,为明天的发展奠定基础。

CPU(中央处理器)可能是当前阶段端侧推理(即在设备本地进行推理)的最优解,那么未来呢?

随着端侧推理的需求不断增加,需要处理的任务变得越来越复杂,数据量也不断增加。当GPU凭借其出色的并行计算能力稳坐云端AI算力的领导地位时,AI芯片市场的竞争也越来越激烈。其中NPU作为一种关键的技术支持,在能耗比方面表现出色,正在逐渐成为实现在终端设备上运行AI大模型的关键技术。

NPU全称为Neural Processing Unit(神经网络处理单元)。从名字就可以看出,它专门针对神经网络进行设计与优化,能更加高效地运行Transformer架构的人工智能模型。

随着人工智能手机和人工智能个人电脑概念的普及,神经处理单元(NPU)的重要性也日益凸显。NPU可以在视频、图像、系统管理等各种场景中发挥出色的人工智能加速能力,以满足不断增长的终端推理需求。

本届微软Build开发者大会上,微软甚至专门定义了AI PC的入门门槛——只有配备性能达到40 TOPS的神经处理单元(NPU),才能被称为AI PC。

回顾国内市场,中国最大的芯片IP设计厂商安谋科技在成立之初就已经开始布局人工智能领域,并在2018年发布了首款本土自研的“周易”神经处理器(NPU)。经过多年的发展,安谋科技相继推出了多款更新版本的“周易”产品,以满足不断变化的计算需求。

其中,“周易”X系列主要面向ADAS、智能座舱、平板电脑、台式机和手机等应用场景提供更高的算力,最高可达320Tops。同时,“周易”NPU针对端侧大模型场景也进行了专门的升级优化,据悉下一代“周易”NPU将会适配国内外多个主流的开源大模型方案,覆盖硬件及其配套的软件工具。

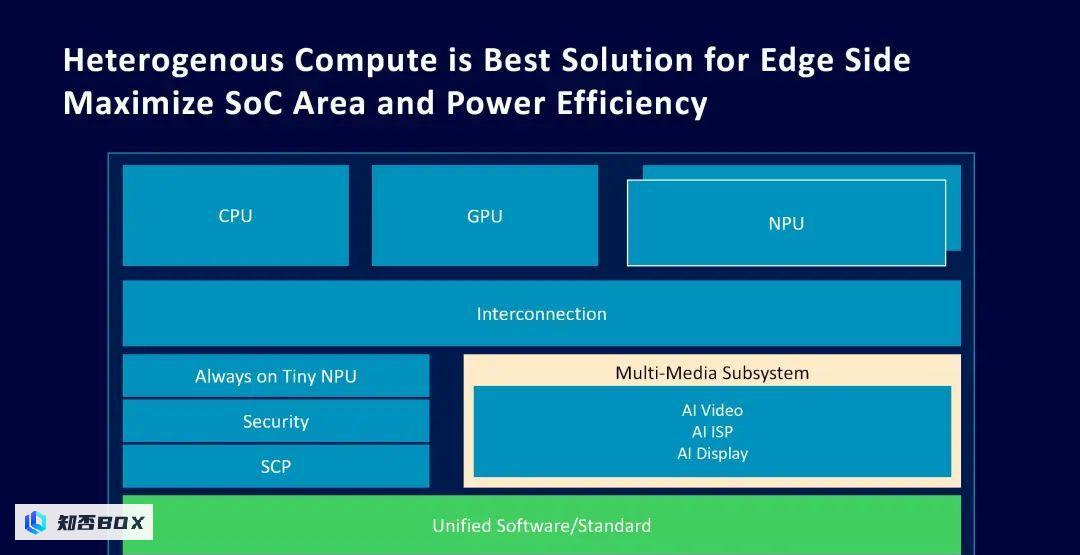

其中,“周易”X系列主要面向自动驾驶辅助系统(ADAS)、智能座舱、平板电脑、台式机和手机等各种应用场景提供更高的算力,最高可达320Tops。同时,“周易”NPU针对端侧大模型场景也进行了专门的升级优化,据悉下一代“周易”NPU将会适配国内外多个主流的开源大模型方案,覆盖硬件及其配套的软件工具。需要明确的一点是,虽然都能解决人工智能需求,但神经处理器(NPU)、图形处理器(GPU)与中央处理器(CPU)并非替代关系。三者通常是集成在一起,形成“CPU+GPU+NPU”的异构计算组合,每个处理器擅长不同的任务。CPU擅长顺序控制和即时性,GPU适合并行数据流处理,NPU擅长标量、向量和张量数学运算,可用于核心人工智能工作负载。

这种异构计算的组合方式,能够实现最佳应用性能、能效和电池续航,以最大化发挥生成式人工智能终端用户体验的优势。

今天,异构计算已经成为芯片公司布局市场不可或缺的一环,为了为未来端侧推理市场的爆发做好准备。

例如,安谋科技结合了Arm中央处理器单元(CPU)、图形处理器单元(GPU)等通用计算单元与本土自研的神经网络处理器单元(NPU),打造了一体化、高质量的异构计算IP平台,支持并推动芯片公司在异构计算领域的创新。

安谋科技的异构计算平台,图片来自安谋科技

安谋科技市场及生态副总裁梁泉认为,未来端侧人工智能(AI)应用将会迎来爆发,不仅需要在高端的异构计算平台上进行样板落地,还需要在大众的终端设备上快速普及。

他表示:“Arm CPU作为普及率最高的计算单元,已经完全可以胜任合适规模的端侧生成式AI计算,且有着极其平衡的能效。配合全新的Kleidi软件,以及Arm持续更新的CPU技术和CSS方案,接下来将成为端侧AI快速普及的核心平台。同时,安谋科技投入研发的‘周易’NPU已历经六年深耕,目前产品将迎来新一轮的迭代升级。在国内市场,我们提供灵活且丰富的计算平台及方案组合,与芯片客户、终端厂商及生态伙伴共同推动端侧AI的高速发展。”

目前,国内外已经有许多GPU和AI芯片企业在云端进行大模型相关工作。然而,在边缘端和终端设备上,还没有一个成熟且统一的硬件平台能够支持将大模型部署到手机、PC或机器人等设备上。因此,这个市场有着巨大的潜力。

但不论市场如何变化,中央处理器(CPU)的重要性都无可替代。Arm终端事业部产品管理副总裁James McNiven在接受采访时表示,无论是CPU还是图形处理器(GPU),即便有人工智能(AI)专用加速器,仍需要计算基础,正如CPU支撑万物。

纵观当前端侧推理的存量市场,中央处理器(CPU)是端侧算力的最佳选择,也是实现端侧推理的起点;而在未来端侧推理的增量市场中,中央处理器(CPU)、图形处理器(GPU)和神经网络处理器(NPU)组成的异构计算平台,中央处理器(CPU)仍然是支撑各种计算任务的核心。

如何充分利用端侧推理能力,有效释放CPU的计算能力,将成为决定端侧大模型应用竞赛的关键因素。