AIGC动态欢迎阅读

原标题:模型

推理速度狂飙 20 倍,又有一家公司想赶超英伟达

关键字:模型,内存,芯片,带宽,参数文章来源:Founder Park

内容字数:0字内容摘要:

曾造出世界最大芯片公司 Cerebras,发布了全球最快的 AI 推理架构——Cerebras Inference。

运行 Llama3.1 8B 时,它能以 1800 token/s 的速率吐出文字。

自推出了使用一整个晶圆制造的芯片以来,Cerebras 在过去几年里的宣传,都是以攻进英伟达所把持的 AI 芯片市场为目标。

以下文章转载自「新智元」和「半导体行业观察」,Founder Park 略有调整。

点击关注,每天更新深度 AI 行业洞察

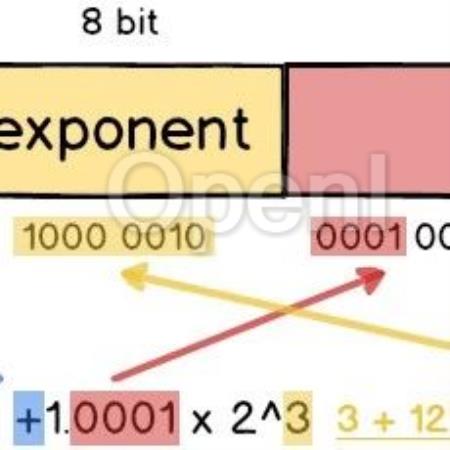

01「全球最快」AI推理服务据首席执行官 Andrew Feldman 介绍,新的 AI 推理架构——Cerebras Inference。通过使用 SRAM,在以 16 位精度运行 Llama 3.1 8B 时每秒能够生成 1,800 个以上的 token,而性能最高的 H100 实例每秒最多可生成 242 个 token。

不论是总结文档,还是代码生成等任务,响应几乎一闪而过,快到让你不敢相信自己的眼睛。

如下图右所示,以往,微调版 Llama3.1 8B 推理速度为 90 token/s,清晰可见每行文字。

而现在,直接从 90 to原文链接:模型推理速度狂飙 20 倍,又有一家公司想赶超英伟达

联系作者

文章来源:Founder Park

作者微信:

作者简介: