AIGC动态欢迎阅读

成为新选择

关键字:模型,内存,服务器,参数,浪潮文章来源:量子位

内容字数:0字内容摘要:

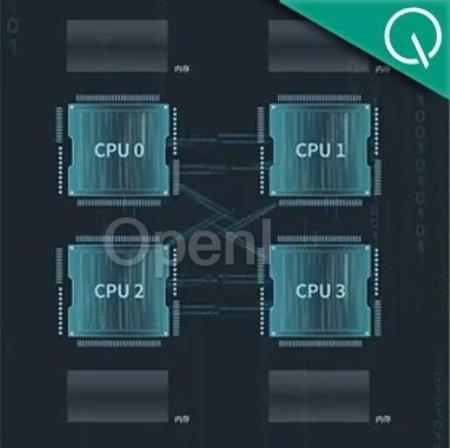

克雷西 发自 凹非寺量子位 | 公众号 QbitAI千亿参数规模的大模型推理,服务器仅用4颗CPU就能实现!

在一台CPU通用服务器上,浪潮信息成功跑通了102B大模型推理。

如果推广开来,没有专用芯片的传统行业,不必更换硬件,也能用上AI了。

△浪潮信息通用服务器NF8260G7服务器成功运行千亿参数大模型这套方案以极低的延时,近乎实时地进行推理运算。

如此之大的模型,只靠CPU运行,究竟是怎么实现的?

4颗CPU带动千亿大模型?用CPU在单台通用服务器设备中运行大模型推理,特别是千亿参数的庞然大物,困难是可想而知的。

要想高效运行千亿参数大模型,计算、内存、通信等硬件资源的需求量都非常巨大。

内存方面,千亿参数大约需要200~300GB的显存空间才放得下。

除了内存资源,千亿参数大模型在运行过程中,对数据计算、计算单元之间及计算单元与内存之间通信的带宽要求也非常高。

按照BF16的精度计算,要想使千亿参数大模型的运行时延小于100ms,内存与计算单元之间的通信带宽至少要在每秒2TB以上。

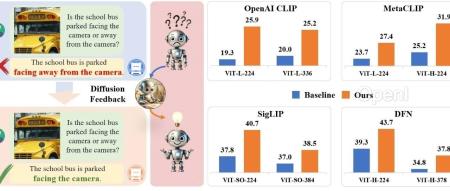

就算解决了这些硬件需求,软件的优化适配同样是一个难题。

由于涉及到大量的并行运算,现有的大模型原文链接:想跑千亿大模型?算力厂商放大招!CPU通用服务器成为新选择

联系作者

文章来源:量子位

作者微信:

作者简介: