AIGC动态欢迎阅读

原标题:大模型

在持续学习中的最新进展:综述

关键字:模型,语言,任务,报告,基础文章来源:人工智能学家

内容字数:0字内容摘要:

来源:专知

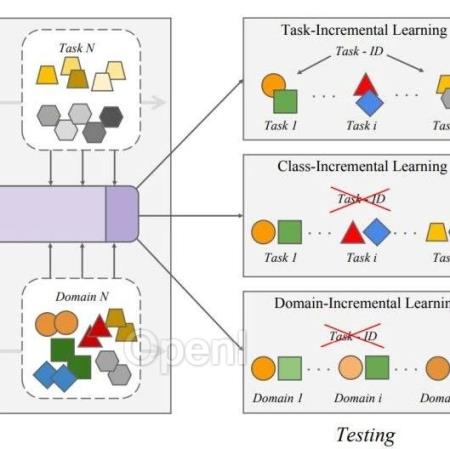

近年来,基础语言模型(LMs)在自然语言处理(NLP)和计算机视觉(CV)领域取得了显著成就。与传统神经网络模型不同,基础语言模型通过在大量无监督数据集上进行预训练,获得了丰富的常识知识,并且具有强大的迁移学习能力。然而,由于灾难性遗忘,基础语言模型仍然无法模拟人类的持续学习能力。因此,各种基于持续学习(CL)的方法被开发出来,以改进语言模型,使其能够在适应新任务的同时不遗忘以前的知识。然而,现有方法的系统分类和性能比较仍然缺乏,这正是本综述旨在填补的空白。我们深入综述、总结并分类了现有文献中应用于基础语言模型的持续学习方法,如预训练语言模型(PLMs)、大语言模型(LLMs)和视觉-语言模型(VLMs)。我们将这些研究分为离线持续学习和在线持续学习,其中包括传统方法、基于参数高效的方法、基于提示调优的方法和持续预训练方法。离线持续学习包括领域增量学习、任务增量学习和类别增量学习,而在线持续学习则细分为硬任务边界和模糊任务边界设置。此外,我们概述了持续学习研究中使用的典型数据集和指标,并详细分析了基于语言模型的持续学习所面临的挑战和未来工作。

1 引言

近年来,基础语言模型原文链接:大模型在持续学习中的最新进展:综述

联系作者

文章来源:人工智能学家

作者微信:AItists

作者简介:致力成为权威的人工智能科技媒体和前沿科技研究机构