AIGC动态欢迎阅读

原标题:原作者带队,LSTM卷土重来之Vision-LSTM出世

关键字:序列,模型,性能,视觉,补丁文章来源:机器之心

内容字数:0字内容摘要:

机器之心报道

编辑:鸭梨、蛋酱与 DeiT 等使用 ViT 和 Vision-Mamba (Vim) 方法的模型相比,ViL 的性能更胜一筹。

AI 领域的研究者应该还记得,在 Transformer 诞生后的三年,谷歌将这一自然语言处理届的重要研究扩展到了视觉领域,也就是 Vision Transformer。后来,ViT 被广泛用作计算机视觉中的通用骨干。

这种跨界,对于前不久发布的 xLSTM 来说同样可以实现。最近,享誉数十年的 LSTM 被扩展到一个可扩展且性能良好的架构 ——xLSTM,通过指数门控和可并行化的矩阵内存结构克服了长期存在的 LSTM 限制。现在,这一成果已经扩展到视觉领域。xLSTM和Vision-LSTM 两项研究均由 LSTM 原作者带队,也就是LSTM 的提出者和奠基者Sepp Hochreiter。

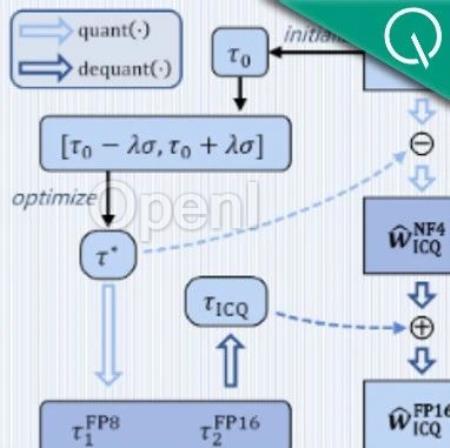

在最近的这篇论文中,Sepp Hochreiter 等人推出了 Vision-LSTM(ViL)。ViL 包含一堆 xLSTM 块,其中奇数块从上到下、偶数块则从下到上处理补丁 token 序列。论文题目:Vision-LSTM: xLSTM as Ge原文链接:原作者带队,LSTM卷土重来之Vision-LSTM出世

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台