AIGC动态欢迎阅读

原标题:ICML2024高分论文!大模型

计算效率暴涨至200%,来自中国AI公司

关键字:彩云,模型,小米,注意力,笔者文章来源:夕小瑶科技说

内容字数:7466字内容摘要:

夕小瑶科技说 原创作者 夕小瑶编辑部前段时间,KAN突然爆火,成为可以替代MLP的一种全新神经网络架构,200个参数顶30万参数;而且,GPT-4

o的生成速度也是惊艳了一众大模型爱好者。

大家开始意识到——

大模型的计算效率很重要,提升大模型的tokens生成速度是很关键的一环。

而提升大模型的tokens生成速度,除了花钱升级GPU外,更长效的做法是改善Transformer模型架构的计算效率。

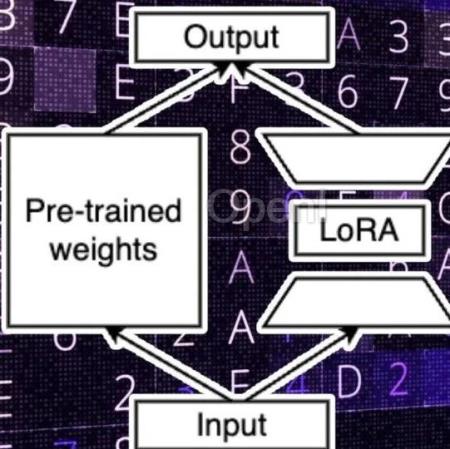

今天,笔者发现,终于有团队对Transformer计算最耗时的核心组件——多头注意力模块(MHA)下手了,将Transformer的计算性能提升了有2倍之高。

通俗的讲,如果这项工作未来能落地到大模型里面,那么大模型tokens生成速度翻倍式提升的一天就不远了。

这篇论文已经被今年的机器学习顶会ICML 2024录用,拿到了7分的高分,而且还开源了。

据透露,今年ICML 2024录用的paper平均得分在4.25-6.33之间

笔者扒了下,发现这个工作的背后是一家颇具影响力的国内公司——彩云科技,没错,就是打造爆火的“彩云小梦”产品的团队。

不急,先看看这篇论文,如何将Transforme原文链接:ICML2024高分论文!大模型计算效率暴涨至200%,来自中国AI公司

联系作者

文章来源:夕小瑶科技说

作者微信:xixiaoyaoQAQ

作者简介:专业、有趣、深度价值导向的科技媒体。聚集30万AI工程师、研究员,覆盖500多家海内外机构投资人,互联网大厂中高管和AI公司创始人。一线作者来自清北、国内外顶级AI实验室和大厂,兼备敏锐的行业嗅觉和洞察深度。商务合作:zym5189