点蓝色字关注“机器学习算法工程师”

点蓝色字关注“机器学习算法工程师”

设为星标,干货直达!

唉,好烦啊 ,每次我写完文章都要为怎么起标题而发愁,生怕吸引不了读者点击进而导致阅读量惨淡。

,每次我写完文章都要为怎么起标题而发愁,生怕吸引不了读者点击进而导致阅读量惨淡。

于是我绞尽脑汁给本文拟好了四个标题发到工作群里,想让编辑部的同事帮忙参考一下,毕竟我这次起的是那么的好,我很有自信 。

。

果然,老板看了我起的标题之后拍案叫好,连忙表示要给我“升职加薪”,把我都给开心哭了 。

。

标题党真是太可怕了,没办法啊,媒体行业现在也是卷的厉害。

好了,现在说回本文,其实本文讨论的就是和标题党相关的话题。

事情是这样的,编辑部的同事淼兄今天在Reddit上刷到了一个热门帖子,帖子里面正在讨论机器学习社区中的论文标题党现象。

发帖的网友yusuf-bengio表示:

还是想念以前那个朴实无华的年代,那时候每个人都会老老实实地写标题,清楚地写明论文的主要研究结果。

yusuf-bengio还将AI圈无人不知无人不晓的GPT-3的原论文《Language Models are Few-Shot Learners》作为良好范例,表示这个标题能很好地指出“只要给定一个大模型和大量的数据,Language Models are Few-Shot Learners”(当然,还是得看看摘要,但至少有说明研究结果)。

然而如今时代变了,大量的论文标题党充斥着整个AI社区,几乎有一百万篇(夸张一下)标题为“XXX is all you need”的论文,已经达到了泛滥的程度。

此外,还有另外一些标题党,只描述方法而不提结果。例如《Reinforcement Learning with Bayesian Kernel Latent Meanfield Priors》(这是编造的标题)。

yusuf-bengio表示,这样的标题自然会比“XXX is all you need”要好一些,但是用“研究者在做的事情”取代了“研究者取得的成果”。(这样把灌水的论文发出去时没那么虚?)

也就是说,像《Bayesian Kernel Latent Meanfield Priors Improve Learning in Hard-to-explore Reinforcement Learning Environments》这样的标题会更好。

帖子下方的网友也纷纷附和,其中一位网友侃道:

以后可能会出现

《我尝试了这个新的目标函数,效果令人难以置信!》、

《我的天,这个新方法会让你大吃一惊!》等等类似自媒体标题党的标题。

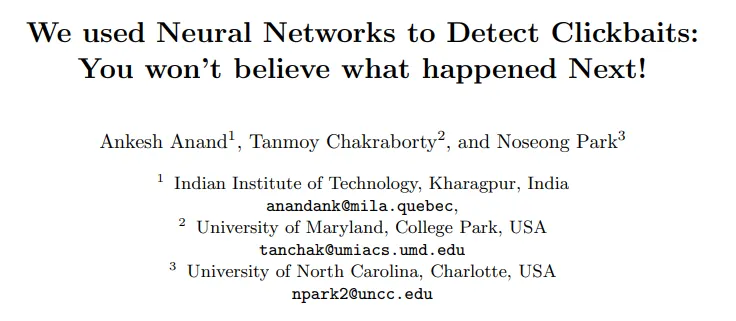

随即,另一位网友啧啧摇头表示道,Too yong too simple,这种标题已经有了:《我们使用神经网络来检测Clickbaits:接下来发生的事情让我怀疑人生!》。

网友Duranium_alloy则认为:

“这样的标题第一次出现还可以接受,但多了就令人厌烦了。第一次出现时一般是由于论文本身的开创性,但如今却成了很多非开创性的增量研究鱼目混珠的手段。那个,我现在也在考虑使用‘The Importance of Being X’这样的标题,大家有尝试过吗?”(为什么要泄露大招呢?)

网友svantevid对“标题党泛滥”的观点表示同意,同时也指出:

“令人遗憾的是,‘醒目’标题确实是吸引注意力的有效方式。我可以接受的折衷方案是,一半标题党,一半严肃标题。例如,‘Mind the GAP: A Balanced Corpus of Gendered Ambiguous Pronouns’。或者,按照华盛顿大学语言学教授Emily M. Bender的说法,使用不常见的双关语,也是一种选择。”

网友GalacticGlum吐槽了一把“XXX is all you need”标题党:“我仍然不理解这是怎么流行起来的,这甚至还不是很好的点击诱饵。除了由于论文受欢迎而使人们想着蹭“Attention Is All You Need”的热度之外,标题真的没啥信息量,我真的不明白。”

网友N的观点是:标题党可怕,但是因为标题太平淡而使得论文不被注意到也是一种可惜(毕竟这是一个AI论文泛滥的时代),平衡永远是最好的。

网友N同时还指出,好的文献检索一般还会关注摘要部分和作者提供的关键字,而不仅是标题。因此,谷歌搜索Transformer仍然给出“Attention is all you need”论文。“当然,与典型的发布者数据库相比,Google做的索引要多得多,但这是相同的概念。”

实际上,“XXX is all you need”标题党鼻祖“Attention is all you need”的这个标题起的确实起的有点标题党,让三金我都自愧不如 。

。

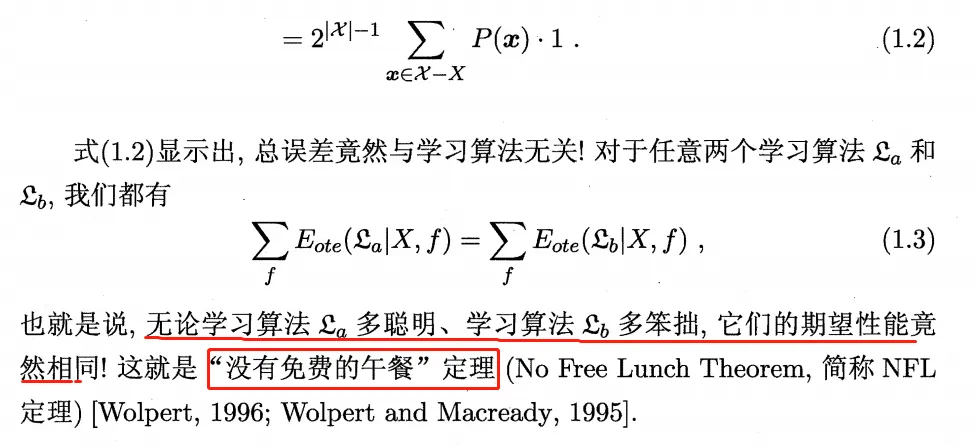

这篇论文提出了Transformer架构,Transformer只用了注意力机制,而没有使用常规的循环连接和卷积操作。这种研究思路在当时确实是突破性的,但论文中也仅将其用于机器翻译任务,并展示了一定程度的多任务泛化性能。“all you need”在严格意义上有表示万能模型的意思,而“没有免费午餐定理”已经否定了万能模型的存在。

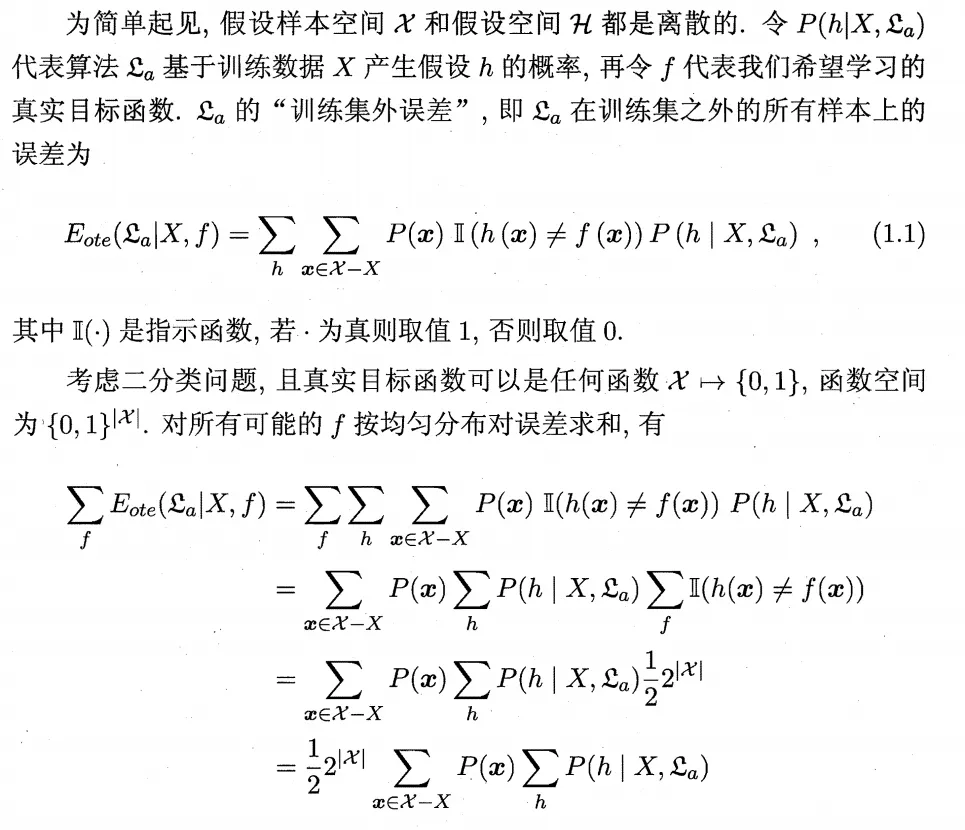

什么是“没有免费午餐定理”?

以下是周志华教授在西瓜书中对该定理的描述:

对于一个学习算法A,若它在某些问题上比学习算法B好,则必然存在另一些问题,在那里B比A好。

周志华教授在西瓜书中为没有免费午餐定理提供了一段小学三年级都能看懂的证明:

如今看来,“all you need”似乎有种预言的意味。

基于Transformer的BERT模型在11种NLP任务上达到SOTA性能,同样基于Transformer的GPT系列更是让人怀疑AI已悄悄产生了意识。Transformer甚至还跳出了NLP领域,闯入CV领域,秒杀CNN。

就在今天,三金我在推特上看到了一篇Transformer在多模态任务学习上的应用,题为《Transformer is All You Need:Multimodal Multitask Learning with a Unified Transformer》的论文,作者还是一位伯克利博士毕业的华人大神,至于这篇论文的工作好坏,我们今天先不谈。

我看到伦敦大学城市学院计算机科学教授Artur对此评价道:“以我的经验来看,你或许总是需要一些别的东西…….”

这位教授估计想要表述的也是没有免费午餐定理:

最近Transformer似乎还应用到了GAN领域,那么请问,Transformer真的万能了吗?

当然不是,这个架构并没有逃出“没有免费午餐定理”的支配。

本质上,注意力机制的归纳偏置相比于循环连接、卷积操作而言更弱。所以,这类架构适用于更广泛的任务,但相应地,训练数据量和计算量也大得多。例如,从千亿级参数的GPT-3,再到谷歌近期提出的万亿级参数模型Switch Transformer,都是基于Transformer的模型,其训练成本也只有巨头企业负担得起。

这其实意味着,对于某些特定任务,还是RNN或者CNN的效率会更高。例如,一些将Transformer应用于CV任务的架构,也会在模型底层(也就是特征提取层)采用CNN架构,然后在模型顶层采用Transformer架构,以捕捉CNN不擅长学习的长程依赖关系。

再进一步来看,Transformer相比于通用近似定理中的“单隐藏层、无限宽神经网络”又有着更强的归纳偏置。所以它终归只能适应某些特定类型的任务,只是我们目前还没有探索尽其可能性。

如果它恰好能适应所有人类应该面对的问题,那自然最好不过,到时候就会出现这样一篇论文:“Attention is all human need”(开个玩笑)。如今,人工智能行业特别是工业界正在以牺牲效率的方式寻找Transformer的边界。科学支持极端主义的行为艺术,但回归人间时,还是效率为王。

到这里,三金我还是比较固执,难道真的没有什么东西是 all you need的吗?

或许有一个,它可能是《Computer is all you need》,或许还可能是《Money is all you need 》 。

。

钱真的那么重要吗?

那是自然。大家都知道的,近些年人工智能真正开始在全球大众范围内火爆起来其实是AlphaGo大战李世石,经此一役,圈内人也都知道了谷歌(DeepMind)的有钱任性,在算力和服务器上的投入真的是前所未有。

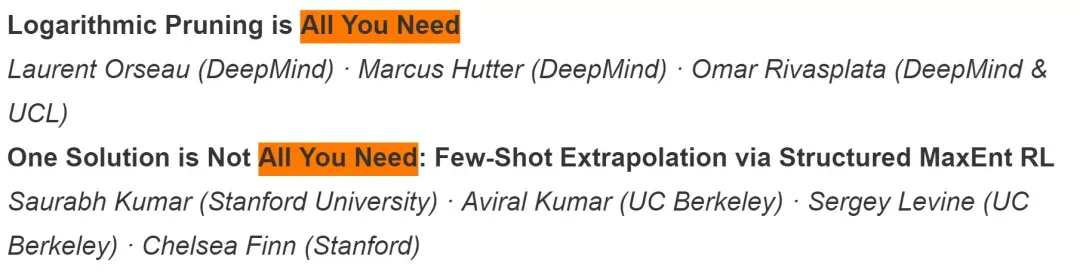

在被NeurIPS 2020接收的论文有两篇:

在被ICLR 2021 接收的有一篇霍普神经网络is All You Need:

难道标题起成这样真的能加大论文录取率?三金我顿时产生了怀疑,难道我也能发顶会论文了?

接下来,三金列举一些论文起名小操作。

一、沾喜气

ACL 2020的最佳论文题目带有Beyond一词,如下所示。

而三金我在ACL 2020几个月后的NeurIPS 2020上发现了5篇题目带有Beyond的论文:

并且其中第一篇论文以Beyond accuracy开头,这和ACL 2020最佳论文题目开头一模一样了,不知道这是不是一个巧合哈,或者说是一个起论文题目风向标,或者是能沾沾喜气?

同样是在NeurIPS 2020被录取的论文中,有五篇论文不是标题党,但是论文标题开头都带有Rethinking:

1、《重新思考标签对改善类不平衡学习的价值》

2、《重新思考预训练和自训练》

3、《重新思考图神经网络的池化层》

4、《重新思考通用特征转换中可学习树Filter》

5、《重新思考分布转移/转换下深度学习的重要性权重 》

这让我想起了CV大神何恺明在被ICCV 2019接收的论文:《Rethinking ImageNet Pre-training》。

嗯这肯定只是巧合了,毕竟大家都可以重新思考的。

所以后来人就应该这样起名:

……………

二、论文起名反向操作

难道针对X is All You Need就没有什么反向操作吗?

微软研究院高级研究员Alex Polozov表示道:

期待第一篇标题大胆的预印本论文:“X 很好,但是或许不是All You Need”

三金我还看到一篇论文的标题是:《你没有时间读这个:一个文本阅读时间预测的探索》。

好吧,那我就不读了,不过这篇论文竟然被ACL 2020录取了,有黑幕!评审员应该没有时间阅读才对。所以这是一个反向操作对吗?

三、论文起名艺术起来

YOLO网络模型的这一名字现在回想起来还是觉得很艺术,You Only Look Once对应单目标检测再恰当不过了。

文末,三金要声明一下自己的观点:

1、其实论文题目怎么起都无伤大雅,跟风也不是大事,说不定跟着跟着自己以后也能引领潮流了,且论文是否被顶会录取也和题目无关,要看论文本身;

2、以上涉及到的论文,只谈到题目,不涉及论文工作,无意冒犯;

3、只要论文工作质量有保障、是原创,论文题目怎么起都行,越开心越好,毕竟谁都不能剥夺大家的起名权。

AI论文起名之荡也就当做一个茶后笑谈吧~

最后借用鲁迅先生的一段话来结尾,这恐怕也是AI圈的一个现象。

凡事总须研究,才会明白。古来时常论文标题党,我也还记得,可是不甚清楚。

我翻开历史论文一查,这论文没有年代,歪歪斜斜的每页上都写着“严谨务实”几个字。我横竖睡不着,仔细看了半夜,才从字缝里看出字来,满本都写着两个字是“灌水”!

参考链接:

https://www.reddit.com/r/MachineLearning/comments/lqh9br/d_a_good_title_is_all_you_need/

推荐阅读

谷歌提出Meta Pseudo Labels,刷新ImageNet上的SOTA!

涨点神器FixRes:两次超越ImageNet数据集上的SOTA

Transformer为何能闯入CV界秒杀CNN?

CondInst:性能和速度均超越Mask RCNN的实例分割模型

centerX: 用新的视角的方式打开CenterNet

mmdetection最小复刻版(十一):概率Anchor分配机制PAA深入分析

MMDetection新版本V2.7发布,支持DETR,还有YOLOV4在路上!

TF Object Detection 终于支持TF2了!

无需tricks,知识蒸馏提升ResNet50在ImageNet上准确度至80%+

不妨试试MoCo,来替换ImageNet上pretrain模型!

mmdetection最小复刻版(七):anchor-base和anchor-free差异分析

mmdetection最小复刻版(四):独家yolo转化内幕

机器学习算法工程师

一个用心的公众号