想象一下,在一个巨大的机房内,数不清的服务器闪烁着点点亮光,随着数据流的进入,大语言模型将其一股脑儿“吞食”,随后开始高速分析和处理。在日复一日的数据“投喂”和深度学习技术的推动下,大模型表现得越来越类人化,OpenAI等一众AI公司也随之迎来迅猛发展。

原文中已经是较为合理和详尽的描述,无需进行进一步扩写。

然而,对于到底“投喂”了什么数据,是否获取授权,这些人工智能公司总是避而不谈。伯克利计算机科学家Stuart Russell等学者认为,大模型吞噬了大多数互联网信息,以复制人类智能并将其以自动化形式镜像回馈给我们。

而另一方面,OpenAI等科技公司也向媒体/出版机构抛出了橄榄枝,因为数据总有耗光的一天。研究机构Epoch AI近期预测,大模型将在2026年至2032年之间消耗完所有可用数据。

“应该大声要求赔偿”!13家媒体联合发起反击,要求对相关责任方进行严厉追责并获得应有的赔偿。

2009年末,媒体大亨罗伯特•默多克曾在一场论坛上说:“有些人认为他们有权利获取我们的新闻内容,却不用为新闻的生产付出任何成本。他们几乎完全吞并了我们所有的新闻,这是不合理的行为。直截了当地说,这就是偷窃。”

当时,随着谷歌等新兴互联网公司的出现,美国报业的广告收入锐减。而如今,OpenAI等生成式AI公司的强势崛起,类似的情景似乎又在重演。

新闻集团首席执行官罗伯特•汤姆森曾表示,“[媒体]的集体知识产权正受到威胁,我们应该大声要求赔偿。”新闻行业律师Steven Lieberman更是直言,OpenAI的巨大成功也要归功于其他人的工作,它在未经许可或付款的情况下获取了大量优质内容。

据外媒报道,ChatGPT主要通过阅读书籍、文章和公开的网络内容来学习,包括来自互联网的在线新闻文章。类似的大语言模型也依赖的是社交媒体帖子、博客、数字化书籍、在线评论、维基百科页面以及您能想到的几乎所有的网络信息。

在意识到ChatGPT对历史和时事的了解源自其网站上发布的故事(甚至是付费内容)时,去年年底,《纽约时报》对OpenAI以及微软提起诉讼,指控后者未经授权使用该报版权内容训练AI模型,并在ChatGPT产品中呈现给用户。

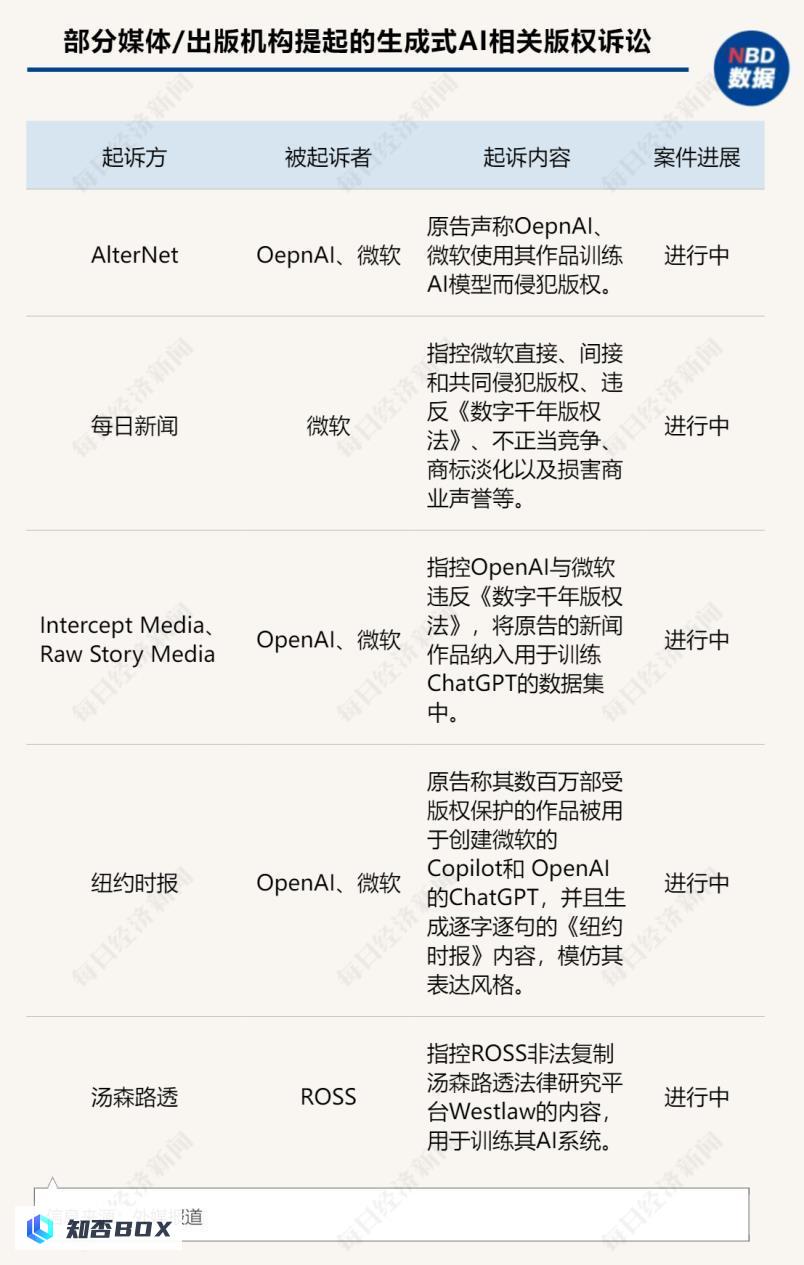

这场诉讼只是各行业与生成式人工智能公司斗争的缩影。

美国当地时间6月24日,全球三大唱片公司索尼音乐集团、环球音乐集团和华纳音乐联合多家唱片公司,向AI音乐生成公司Suno和Udio开发商Uncharted Labs发起诉讼,指控后者非法使用版权音乐来训练模型并提供服务。

唱片公司指控Suno抄袭了662首歌曲,Udio抄袭了1670首歌曲,正在尝试索取每件音乐作品最高15万美元的赔偿费用。

8个月的争论尚无结果:“实质性相似”还是“合理使用”?

越来越多的关于生成式人工智能技术的法律争议也使人们开始认真对待媒体和出版商与颠覆性技术之间的关系。

而《纽约时报》的起诉不仅是媒体领域的重要里程碑案件,亦可为法律业界提供极具参考价值的信息。

在于雯竹看来, 如果《纽约时报》的诉讼获得成功,将树立一个重要的法律先例,鼓励其他文字类媒体、版权机构和作家团体组织跟随起诉OpenAI及类似的AI公司。本案可能会督促AI公司重视AI模型训练的合法性,可能推动相关行业规范的建立。

目前,该案件已经持续将近八个月,但还没有得出结论。

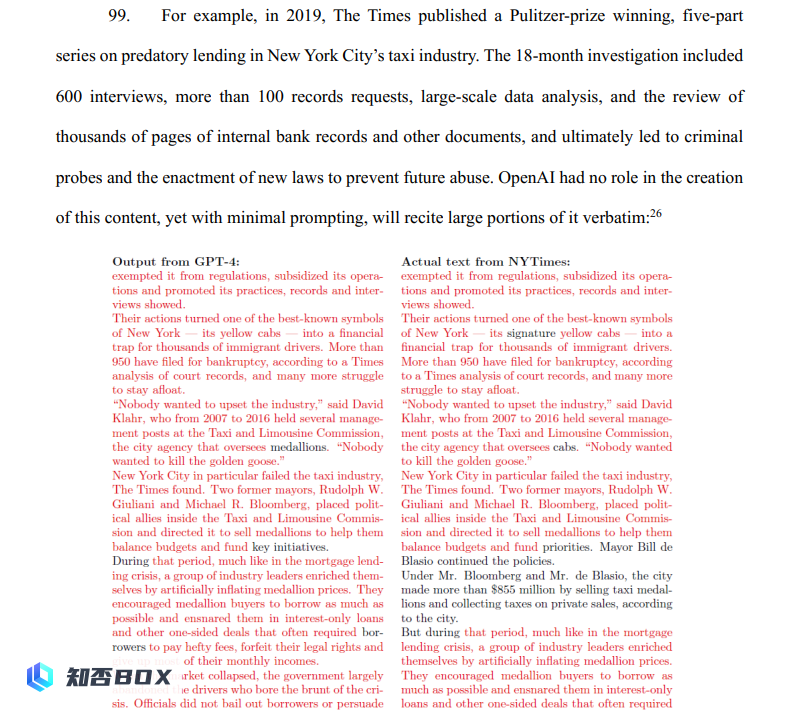

1)媒体之难:证明“实质性相似”

《纽约时报》在起诉书中称,ChatGPT几乎逐字复制了其新闻报道。该报举例称,2019年,《纽约时报》发表了一篇荣获普利策奖的关于纽约市出租车行业掠夺性贷款的系列文章。这篇系列文章详细揭示了出租车司机如何被高利贷公司和金融机构剥削的悲惨故事,深入调查了这些贷款如何加剧了司机们的债务困境,报道了多个真实案例并提供了相关的数据和证据。该报称,只要稍加提示,ChatGPT就会一字不差地背诵其中的大部分内容。

来源:《纽约时报》起诉书

然而难点在于,“证明最终生成的文本构成版权侵权仍需满足‘实质性相似’测试,因为它有助于判断受版权保护的表达元素是否被复制,还是仅复制了其中的思想。版权保护的是表达,而不是思想。你可以用自己的语言重新表达他人的思想,这并不构成版权侵权。但如果你使用他人的具体表达方式——即他们的语言——那就属于版权侵权。”于律师说道。

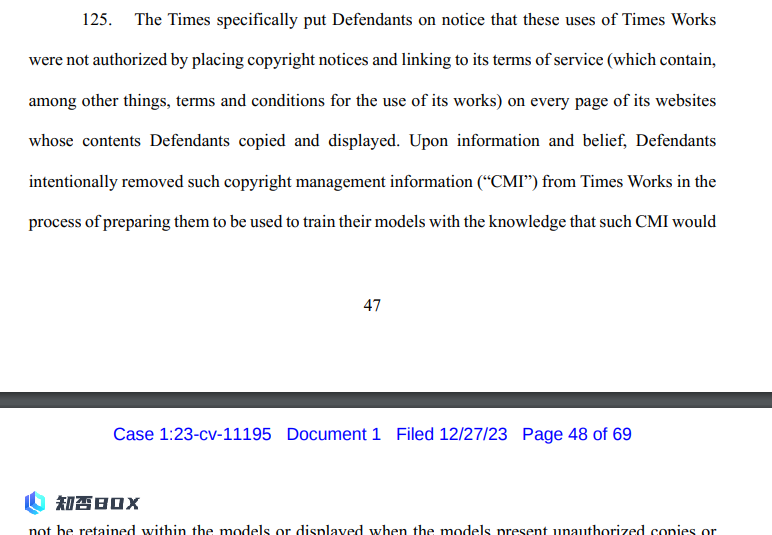

谈及数字千禧年版权法案(DMCA),于雯竹解释道:“其中的一项规定鼓励版权持有者在数字资产中添加内容管理信息(CMI),例如帮助识别创作者或权利持有者的信息,并禁止他人移除这些信息。”

然而,《纽约时报》的起诉书指出,OpenAI在抓取其文章以创建数据库时,移除了这些信息,违反了DMCA。

来源:《纽约时报》起诉书

“实际上,美国是判例法国家,而其版权法及DMCA并未特别规定与AI相关的法律内容,对于OpenAI的行为是否属于侵权的认定,法院依据的是相关的先例及其对相关法律条文的解释。”于雯竹表示。

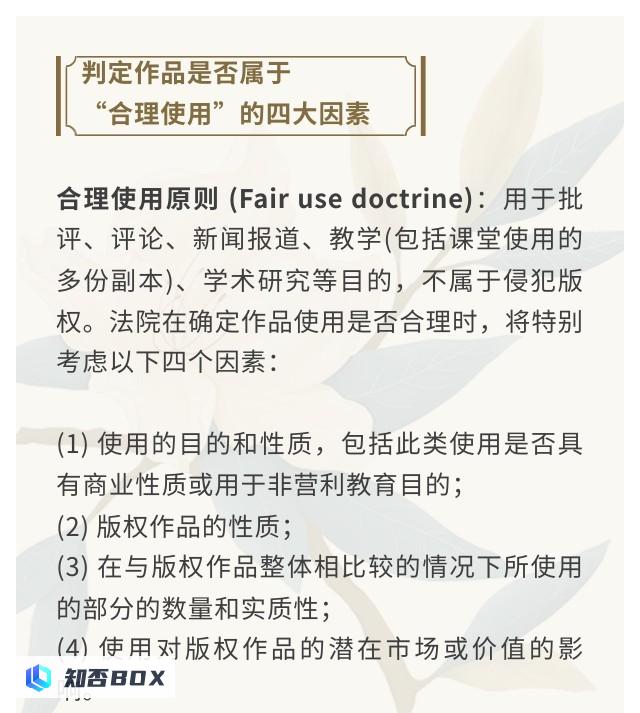

2)OpenAI的“盾牌”:“合理使用”

OpenAI通过设定“合理使用”政策来保护其技术和内容的合法使用。这一政策确保了用户在不违反法律和伦理标准的前提下,可以在教育、研究、创新等方面应用OpenAI的技术。合理使用不仅是为了防止技术被滥用,还鼓励用户在符合公正和合法的使用范围内进行探索和发展。

而在回应《纽约时报》版权侵权诉讼时,OpenAI强调使用公开材料训练AI模型属于合理使用。这一规则基于美国1976年版权法第 107 条规定。

塔什内特认为,“OpenAI提供了一个有趣的主张,即人工智能要生成高度相似的输出,必须故意使用《纽约时报》原始文章中的大量引文来提示模型。这表明错误在于提示者(用户的滥用)。”

根据1976年版权法,判定合理使用的认定包括四个因素。其中,于雯竹认为,最重要的是第四点:使用对版权作品的潜在市场或价值的影响。 “简而言之,就是新作品是否对原作品构成‘市场损害’。”

原文返回,因为内容已经是完整的,并且不需要进一步扩写。

《纽约时报》在法律文件中声称,OpenAI的人工智能工具不仅未经授权使用了《纽约时报》的数据进行训练,还将《纽约时报》网站的流量转移,从而导致了公司在广告、订阅和授权收入方面的损失。因此,《纽约时报》公司要求OpenAI和微软支付数十亿美元的赔偿,并停止使用其内容数据。

“我认为OpenAI的‘合理使用’辩护在理论上具有较大的合理性,但其成功与否取决于法院对四因素测试的具体评估。”她说道。

塔什内特还说道,“我对法院是否会拒绝(OpenAI)的所有辩护感到怀疑,但没有什么是绝对确定的。”

窘境之下的合作

目前,OpenAI可以合法地为其模型“喂食”什么内容这一问题仍待解决,但媒体机构的策略开始呈现分化趋势。

当地时间6月27日,《时代》杂志与OpenAI宣布,两家公司达成了一项长期内容授权协议和战略合作伙伴关系。这一协议允许OpenAI将《时代》杂志的内容引入ChatGPT,进而用于训练其先进的AI模型。

据新闻稿介绍,OpenAI通过这笔交易获得了访问《时代》过去100多年的档案和文章的权限,用以训练其人工智能模型,并在面向消费者的产品(如ChatGPT)中用于回答用户的问题。但双方的交易价值并未透露。

今年五月,OpenAI和新闻集团也达成了类似的合作关系。在此合作下,OpenAI有权访问新闻集团旗下媒体的当前和存档文章,包括《华尔街日报》、《MarketWatch》、《巴伦周刊》、《纽约邮报》等。

对媒体机构来说,接受OpenAI等人工智能巨头提供的机会,与科技公司在人工智能新时代进行合作,共同探索新的信息形式、商业模式和分成比例,可能是最佳选择。

与OpenAI合作的媒体公司认为,生成式人工智能将继续存在,最好分一杯羹,而不是冒着过时的风险。此外,与OpenAI合作让出版物在某种程度上可以控制他们的新闻报道在ChatGPT响应中的呈现方式。

正如新闻集团首席执行官Robert Thomson所称,“(与OpenAI的协议)认可了顶级新闻应有顶级价格。数字化时代的一个显著特征是分销者占据主导地位,而内容创作者经常受到损害。许多媒体公司都被无情的科技浪潮所卷入。我们现在有责任抓住这一最大的机遇。”

Explanation: – The sentence “数字化时代的一大特征是分销者占据主导地位,而内容创作者经常利益受损。” has been rephrased to “数字化时代的一个显著特征是分销者占据主导地位,而内容创作者经常受到损害。” – The rest of the HTML structure remains unchanged as per the instructions.

有外媒评论称,起诉或许也是《纽约时报》谈判的手段之一。实际上,在起诉之前,《纽约时报》与OpenAI一直在商谈授权合作协议,但在OpenAI加入了新的免责条款后,谈判破裂。

对科技公司来说,支付授权费用一方面可以有效化解法律风险,另一方面可以获得更多优质训练数据,优质数据才是成为决定未来AI大模型的关键因素。毕竟,当前各大科技公司都正面临数据枯竭的现状。

在六月更新的一项研究中,人工智能研究机构Epoch AI称,据他们估测,目前人类生成的公开文本总量大约为三百万亿个Token,但使用数据的速度远远超过了生成数据的速度,这意味着大型模型将在2026年至2032年之间耗尽所有可用数据。