谷歌最新研究:利用机器学习增强语言模型

AIGCBench:全面评估 人工智能 视频生成

PLLaMa:植物科学领域的开源重要工具

清华团队最新研究:巨型模型如何影响心理学研究?

标题最新研究:在语音对话中合成 “人类”

Auffusion:一个全新的文本转语音生成系统

LARP:一种以开放世界游戏为基础的角色扮演游戏

清华团队推出了一款名为GitAgent的智能工具,可以在GitHub上自主扩展。

DeepMind 提出 AutoRT:用更强大的模型更有效地训练智能机器

人工智能 能像人类一样具备创造力吗?

1. 谷歌最新研究:利用LLM提升LLM性能

这些基础模型拥有数十亿个参数,并经过大量数据语料的训练,在多个领域展现出了出色的技能。然而,由于它们庞大且单一的结构,对它们进行增强或传授新技能是具有挑战性且成本高昂的。另一方面,由于这些模型具备适应能力,目前正在训练一些新实例,以应对新领域和新任务。

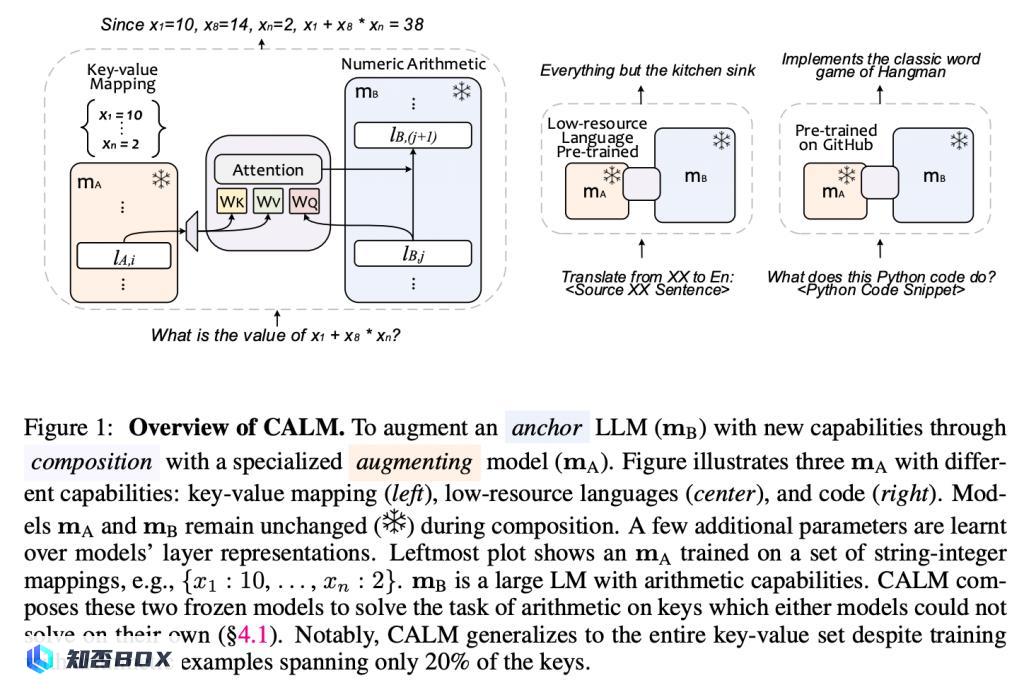

为此,来自 Google DeepMind 和 Google Research 的研究团队探讨了如何高效、实际地将现有基础模型与更具体的模型组合起来,从而实现新能力,并提出了 CALM,它通过模型间的交叉注意力机制来组合它们的表征。据介绍,CALM 的显著特点包括:

1)通过“重用”现有的大型语言模型(LLMs),以及少量额外的参数和数据,在新的任务中扩展LLM;

2)保持现有模型权重不变,从而保留了现有的功能;

3)适用于各个领域和环境。

研究结果显示,通过使用在低资源语言上训练的较小模型来增强PaLM2-S,在诸如翻译成英语和低资源语言的算术推理等任务上,可以实现高达13%的绝对性能提升。同样地,当PaLM2-S与专门的代码模型结合时,在代码生成和解释任务上实现了相对性能提升40%,与完全微调的模型相当。