大模型是世界模型吗?UA微软等机构最新研究发现,GPT-4在复杂环境的模拟中,准确率甚至不及60%。对此,LeCun激动地表示,世界模型永远都不可能是LLM。

一直以来,对LLM(Language Model)的支持观点之一,就是模型可以集成大量的事实知识,作为通往「世界模拟器」的基础。

虽然也有不少人提出反对,但没有确凿的证据。

那么,LLM(Language Model)可以作为世界模拟器吗?

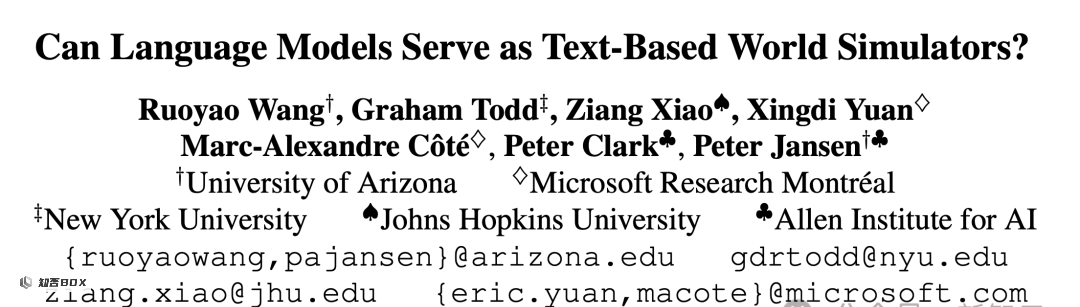

最近,亚利桑那大学、微软、霍普金斯大学等机构联合发布了一篇论文,通过实证研究得出了否定的结论。

最新研究已被ACL 2024顶级学术会议接收。

论文地址:https://arxiv.org/pdf/2406.06485

研究发现,GPT-4在模拟基于常识任务的状态变化时,比如烧开水,准确度仅有60%。

论文认为,尽管GPT-4这样的模型表现非常出色,但如果没有进一步的创新,它就无法成为一个可靠的世界模型。

为了评估LLM的规划能力,作者提出了一个全新的基准测试——bytesized32-state-prediction,并在该测试上使用了GPT-4模型。

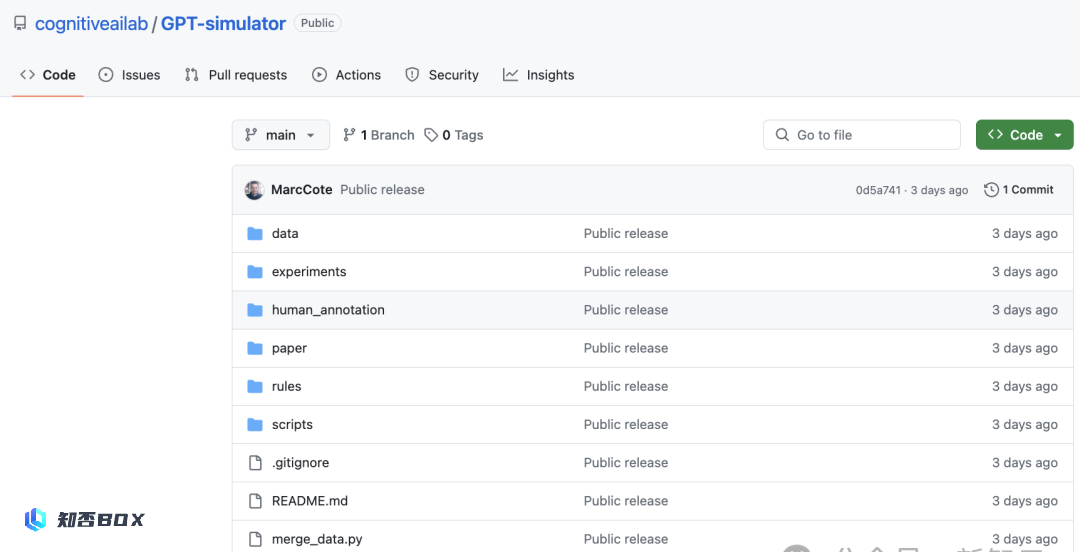

基准测试的代码和数据也已经在GitHub上开源,可以帮助未来的研究者进一步探索LLM的能力、优点和缺点。

https://github.com/cognitiveailab/GPT-simulator

一向对自回归语言模型无感的LeCun也转发了这篇论文。

他用了非常坚定的语气表示,「没有全面的世界观,就没有有效的规划能力」。

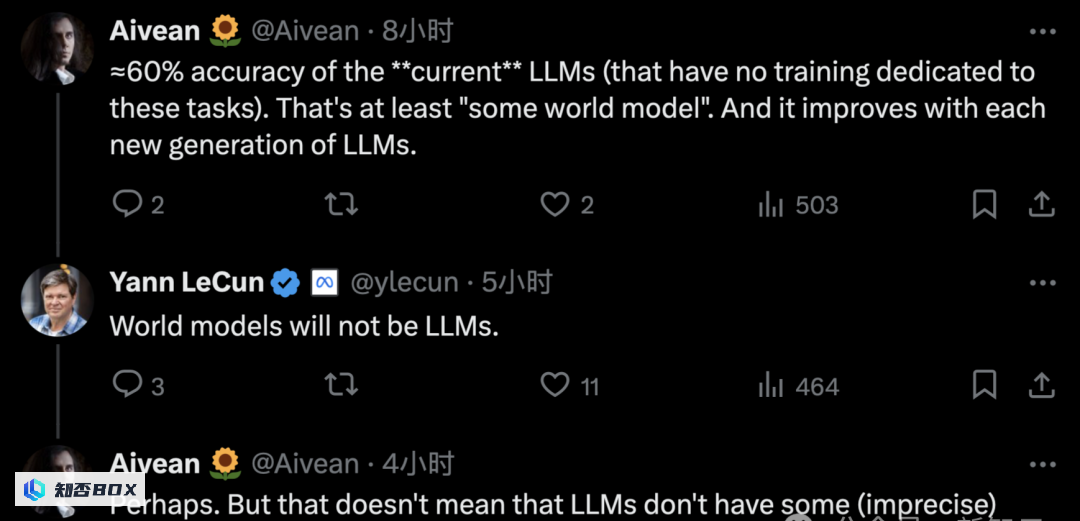

虽然如此,只凭一篇论文又怎么能平息LLM界的重大分歧?支持语言模型的网友很快就在评论区下面反驳LeCun——

网友:目前的LLM(语言模型)能够达到约60%的准确率(在没有专门为任务进行训练的情况下),这至少表明它具备某种「世界模型」,而且每一代LLM都在不断提升。

LeCun:世界模型不会是低级语言模型(LLM)。

网友:也许吧。但这并不意味着LLM内部不存在某种(不准确的)世界观。

不过,在Hinton看来,人工智能已经不再是仅仅依赖于过去,基于统计模型做下一个token的预测,而是展现出更高的「理解」能力。

然而,要成为世界终极模拟器,大模型还有很长的路要走。

LLM是「世界模拟器」吗?

模拟世界,对于人工智能的学习和理解世界至关重要。

以往,多数情况下,由于现实条件的限制,模拟的广度和深度受到了一定的限制。因为需要人类专家花费数周甚至数月的时间来进行大量的工作。

而现在,大模型提供了一种替代的方法,即通过预训练数据集中大量知识,获得对世界的深刻理解和广泛的认知。

但是,它们准备好,直接用作模拟器了吗?

对此,这项研究的团队在「文本游戏」这一领域进行了实验,以验证这一问题。

一般来说,在世界建模和模拟的背景下,应用LLM(逻辑语言模型)有两种方式:一是采用神经符号化方法,即将神经网络与符号逻辑相结合,以实现更高层次的推理和理解能力;二是直接模拟,即通过模拟现实世界的各种因素和变量,来预测和分析可能的结果。

在论文中,研究人员首次对LLM(低层次模拟)在模拟虚拟环境方面的能力进行了量化分析。

他们利用JSON模式的结构化表示作为脚手架(scaffold),不仅提高了模拟精度,还可以直接探查LLM在不同领域的能力。

结果发现,GPT-4普遍无法捕捉与智能体行为无直接关联的「状态转移」(state transition)。

结果发现,GPT-4普遍无法捕捉与智能体行为无直接关联的「状态转移」(state transition)现象。

甚至还包括涉及算术、常识或科学推理的状态转移。

在各种不同条件下,对于模拟一些复杂环境变化时,GPT-4的准确率不及59.9%。

同时也表明,LLM(Language Model)还不足以可靠地充当世界模拟器。

那么,研究人员具体如何实现的?

研究方法

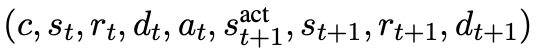

他们将文本的虚拟环境形式化,建模为一种马尔可夫决策过程(POMDP),其中包括以下7个元组:状态(S)、动作(A)、转移函数(T)、观测(O)、奖励(R)、成本(C)和折扣因子(D)。

其中,S表示状态空间,A表示行动空间,T:S×A→S表示状态转移函数,O表示观测函数,R:S×A→R表示奖励函数,C表示用自然语言描述目标和动作语义的「上下文信息」,D:S×A→{0,1}表示二元指示函数,用0或1标记智能体是否完成任务。

其中,上下文C为模型提供了除环境外的其他信息,例如行动规则、物体属性、打分规则和状态转换规则等等。

然后,研究人员还提出了一个预测任务,称为LLM-as-a-Simulator(LLM-Sim),作为一种方法来定量评估大模型作为可靠模拟器的能力。

LLM-Sim任务被定义为实现一个函数,该函数的目标是:

作为世界模拟器,将给定的上下文、状态和动作(即)进行模拟和仿真。

)映射到后续的状态、奖励和游戏完成状态(即

)。

每个状态转移用如下的九元组表示:

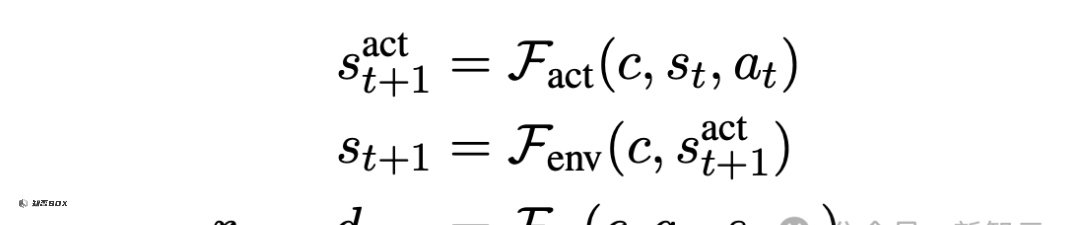

实际上,整个状态转换模拟器F,应该考虑两种类型的状态转移:行为驱动的转移和环境驱动的转移。

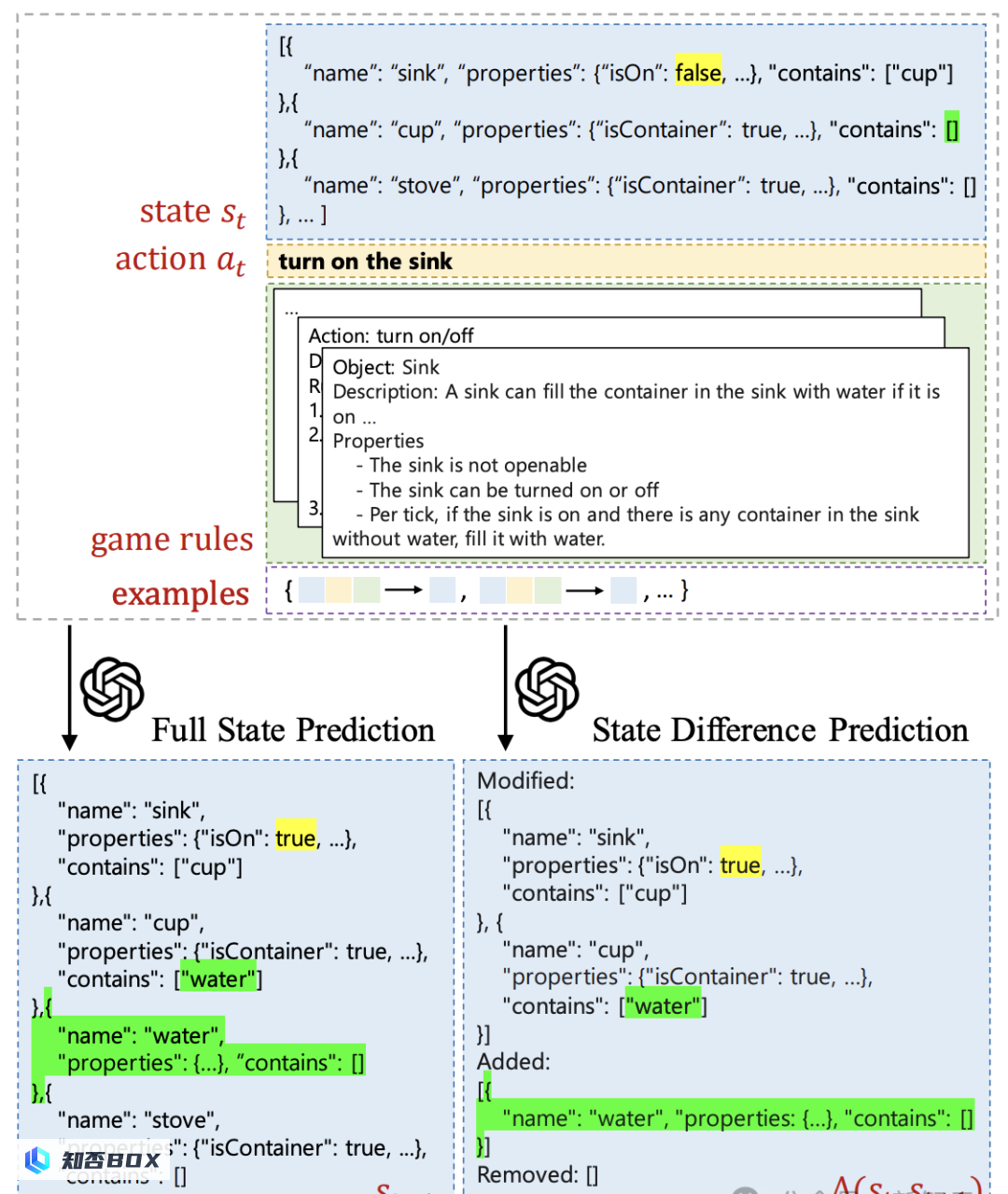

对于图1中的示例,行为驱动的状态转移是在执行「打开水槽」动作后,水槽被打开。而环境驱动的转移是,当水槽打开时,水将自动流入槽中的杯子。

此外,LLM的预测模式还可以分为两种:一种是预测下一步的完整状态,即预测未来的状态;另一种是预测两个时刻之间的状态差,即预测状态的变化。

为了更好地理解LLM(语言模型)对于每种状态转移的建模能力,研究人员进一步将模拟器函数F分解为三种类型:

评估结果

在建模了LLM(Limited Liability Model)的决策过程之后,作者还使用文本构建了一个虚拟人物场景。

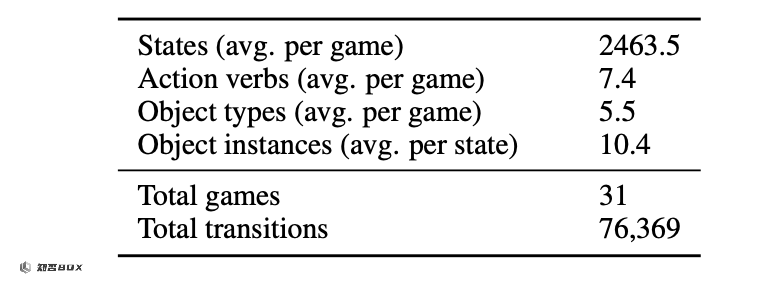

Bytesized32-SP基准测试的数据来源于公开的Bytesized32语料库,该语料库包含了32个由人类编写的文字游戏。

在添加了一个金标签的游戏之后,测试集共涉及了31个不同的游戏场景,其中包含了超过7.6万个状态转换。

LLM(Language Learning Model)根据上下文和前一个状态进行单步预测,给出下一步时的物体属性、任务进展等详细信息。

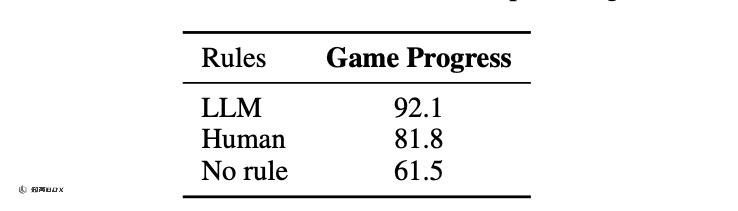

规则方面,研究人员也提出了三种设定:由游戏作者撰写、由LLM(机器学习模型)自动生成,或者根本不提供规则。

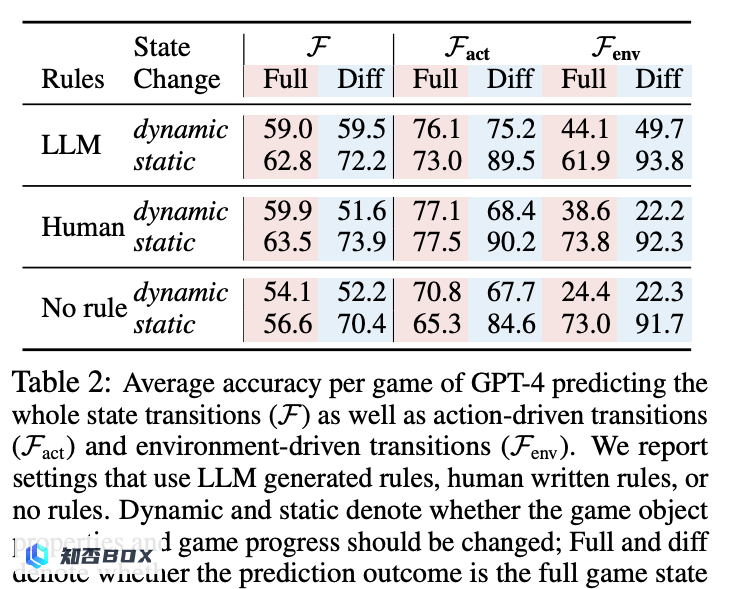

设定好虚拟环境和任务规则后,作者运行GPT-4进行预测得到了如下结果。

为了保持严谨性,作者根据状态转移前后预测结果是否发生变化,将其分为静态和动态两类进行分开统计。如果在前后两个状态中,结果没有发生变化,LLM也更容易进行预测。

不出意料,静态一栏的准确率基本都高于动态。

对于「静态」转移模型来说,当预测状态差时,它的表现更好。而对于「动态转移」模型来说,则相反,在完整状态预测中得分更高。

作者推测,这可能是因为在预测状态差时,需要减少可能出现的格式错误,这会给任务的输出增加额外的复杂性。

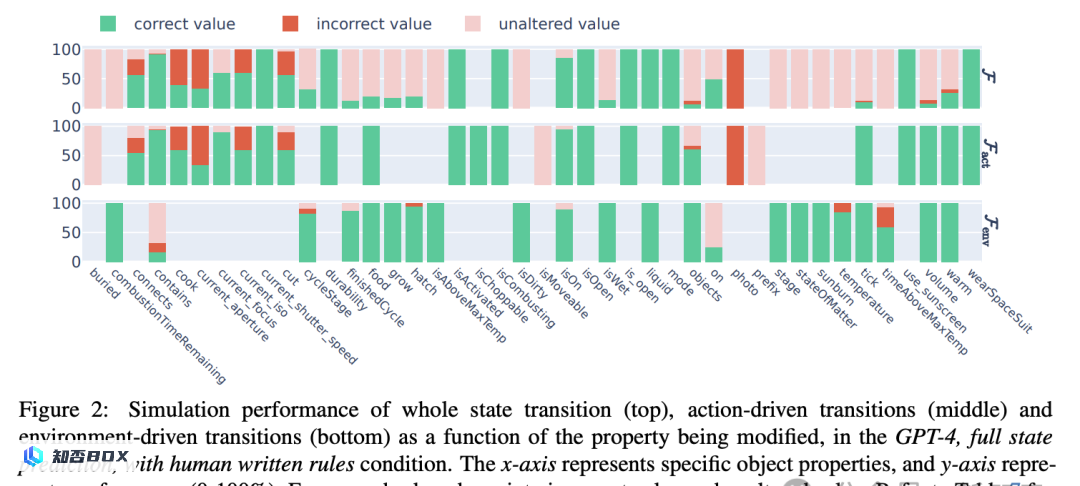

还可以看到,预测动作驱动的状态转移的准确率往往高于环境驱动类。在dynamic栏,前者预测最高分有77.1,而后者最高只有49.7。

此外,游戏规则的制定方式将对LLM的表现产生重要影响。

如果没有提供游戏规则,LLM的预测性能会显著下降,但是无论是由人类制定规则还是由LLM自动生成规则,都不会对准确率产生明显影响。

相比之下,规则制定对游戏进度预测的影响更加显著。

相比于人类制定的规则,GPT-4生成的规则在预测方面提升了超过10个百分点。这是否意味着GPT-4更擅长相互理解?

以上结果都只是针对法学硕士(LLM)在不同设定下的性能比较。和人类预测相比,结果如何呢?

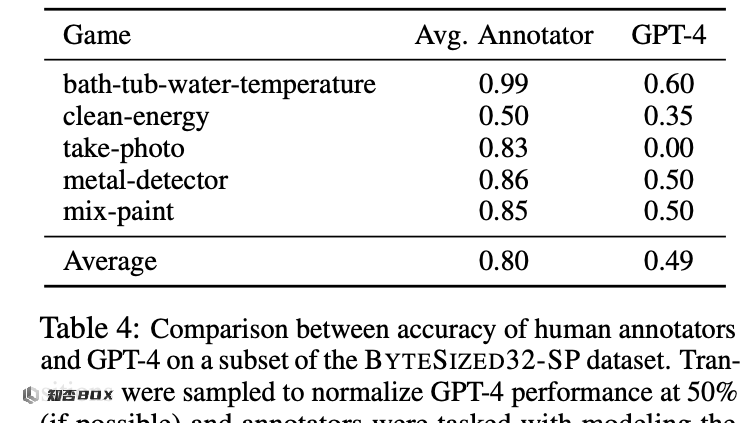

为此,4位论文作者亲自上阵和GPT-4(第四代生成对抗网络)进行一场激烈的对决。

不知道李世石看到这个结果会不会有所安慰。人类的总体准确率在80%左右,远高于GPT-4在50%附近徘徊的成绩,这显示了GPT-4在规划能力上存在重大差距。

对于规划任务中的单步预测模型,每一步的模拟误差都会逐渐累积并向后传播,单步的低性能会在很大程度上影响整体的表现。

此外,人类准确率的波动幅度基本不大,说明任务设定相对简单、直接,适合人类的思维模式。

GPT-4这种性能较差的表现给我们提供了一个重要的机会,可以更详细地分析LLM在哪些方面存在能力缺陷。

因此,论文作者将LLM的预测结果进行详细的分析,发现在二元布尔值属性上(以is开头的属性),模型通常能够取得良好的效果。

预测表现比较糟糕的,通常是一些非平凡属性,比如需要算术运算的温度(temperature)、需要常识的当前照相机光圈(current aperture),或者需要科学知识的灯泡是否打开(on)。

相比之前的基准测试,这似乎更准确地揭示了LLM在常识和科学推理方面的不足之处。

此外,这也能反映出模型在某些行为上的”过度关注”。

在进行完整预测时,它通常过于关注动作驱动的状态转移而忽略了环境驱动,出现了很多「未改变值」的错误。然而,可以从分开预测的结果中看到,这些错误是本可以避免的。

作者提出,这篇文章的局限性之一是只使用了GPT模型进行测试,也许其他模型可以有不同的表现。

这项研究的意义更在于提出了基准测试,为了探索LLM在「世界模拟器」方面的潜力,提供了一套可行的问题形式定义和测试流程。