三个月已经过去了,最初的 “开源落后论” 再次被证明是错误的。

而打脸的人,仍然是上次那位,元宇宙倡导者,前半职业拳击手,潜伏在硅谷的纯正蜥蜴人,马克·扎克伯格。

好吧不卖关子了,简单来说就是,开源 AI 界扛把子 Meta AI ,昨晚更新他们最新最强的大模型, Llama3.1 。

这玩意跟上次 Llama3 一样也是三个版本,除了同参数量的 80 亿和 700 亿,这次最亮眼的是他们的超大杯,在老黄数万显卡的供应下,小扎的新模型用了足足 4050 亿参数!

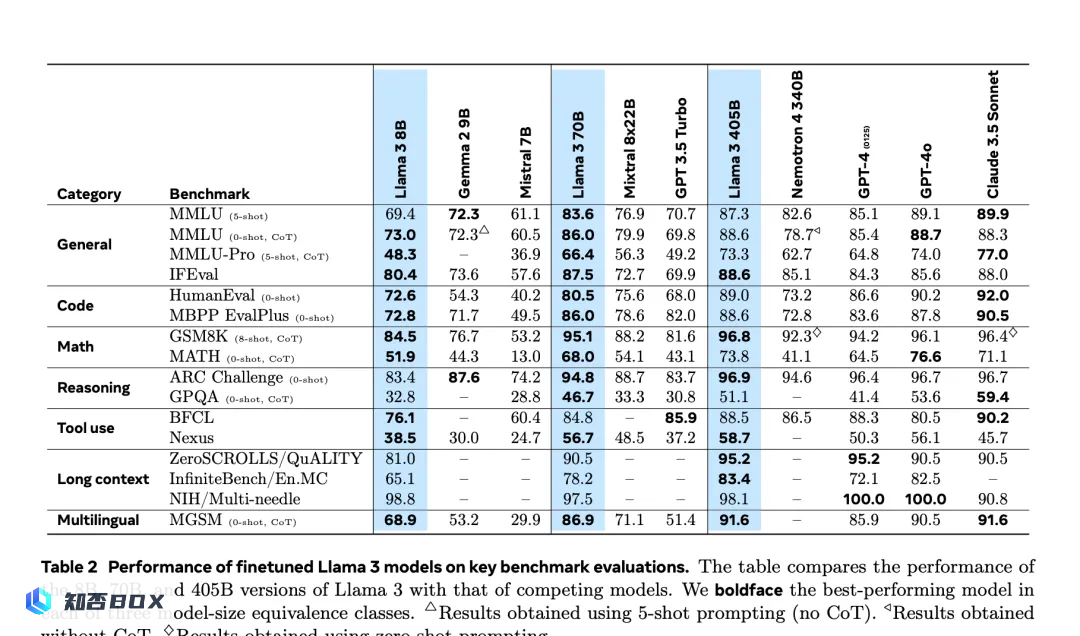

而它的性能,也号称已经完全追上 ChatGPT4o 和 Claude3.5-Sonnet ,像长文本和数学这些方面甚至超过他俩。这回啊,是开源的胜利!

硅谷的其他大佬也对这个模型非常看好,斯坦福大学计算机教授、谷歌 AI 负责人 Andrew Ng 感叹说,Meta 的这次更新,对所有人来说都是非常棒的礼物。

英伟达科学家,AI实验室负责人Jim Fan甚至认为,比肩GPT-4的力量已经发送到大家手中了,这是个历史性时刻!

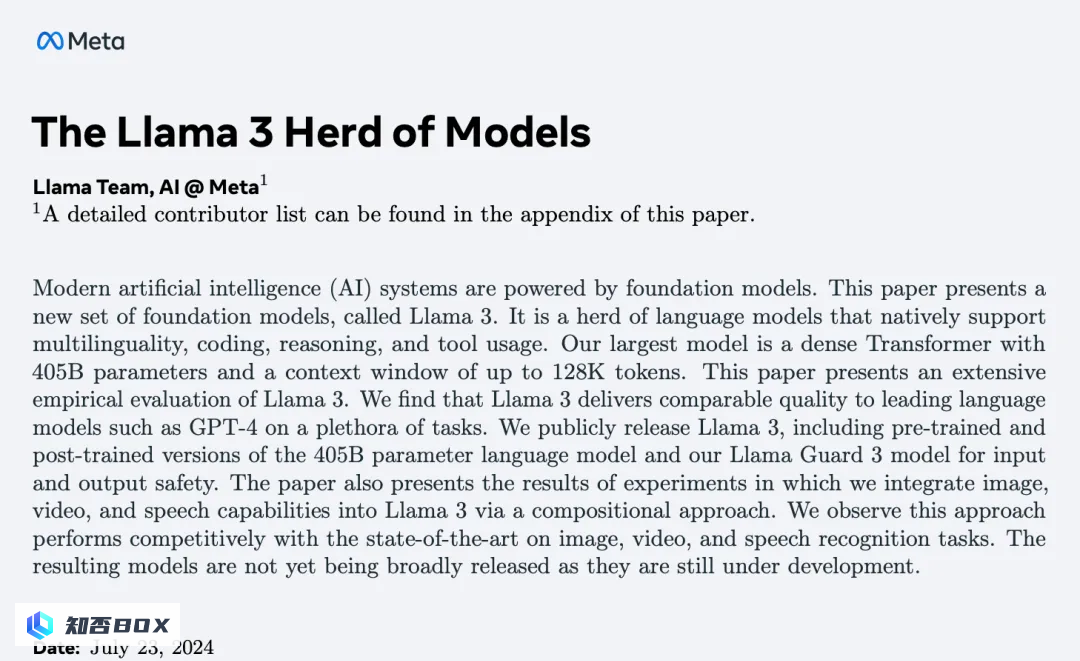

不少媒体也跟着爆发,声称人工通用智能(AGI)的实现已近在眼前了,然而我觉得还是要稍作警醒,建议大家不要急于投入狂热,因为Meta AI官方这次也发布了Llama3.1的详细论文,整整有90页。

这个版本究竟改进了什么地方,是不是真有夸大其词的地方,那论文里其实都写上了。

咱们也花了一个下午,研究了一番,发现这篇论文涵盖了预处理、生成训练、推理训练、退火迭代、多模态评估等流程,但核心其实说的就是两件事,一是大量的训练,二是训练里做了些优化。

首先咱就说训练这方面,他们就下了大功夫,进行了算力和数据的增加。

毕竟人家用了一万六千台 H100 跑了三亿九千三百万 GPU 小时(相当于单块 GPU 三千九百三十万个小时的计算量)。运算规模比 Llama2 翻了五十倍,还填了包括多种语言的十五万亿 Tokens,相当于七千五百亿单词进去,而上代版本只有一八万亿 Tokens。模型上下文窗口也从八千增加到一百二十八千,扩展了十六倍。

数据和运算规模上去了,能力肯定也就上来了,突出一个力大砖飞。毕竟这么多东西,要咱学大概率摆烂学不动,但人家 AI 是真学啊。

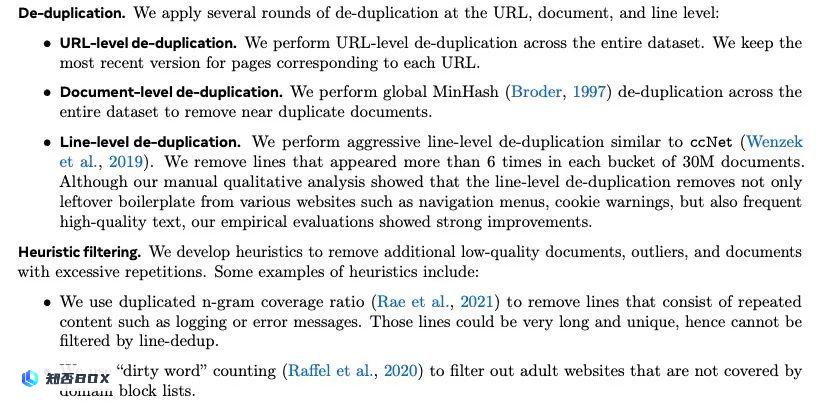

其次,除了填鸭式训练,训练内容里的优化和微调也十分关键,这也是他们能迅速进步的另一个因素。例如,在处理训练信息的初始阶段,他们就采用了若干算法,用以清理重复内容和垃圾信息,以提升训练数据的质量。

你可别说这操作不重要,上回某知名 AI 就在中文垃圾信息上翻车了,成了贻笑大方的典型。

这里他们描述了重复数据删除和启发式过滤两个算法的步骤

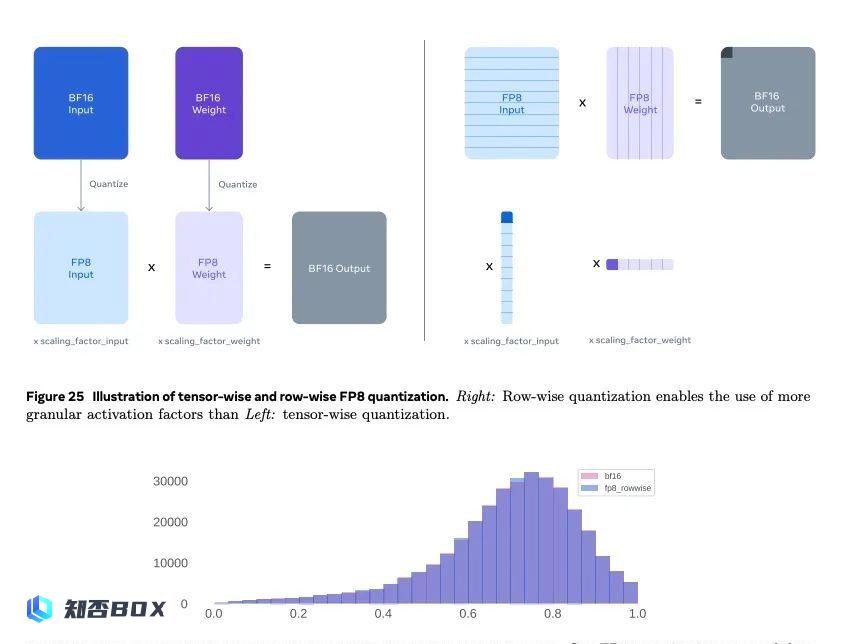

而在模型结构上,为了照顾如此大量的数据训练,Meta还进行了许多改进。例如,他们将训练数据的精度从16位降低到8位。这样不仅可以节省存储空间,还有助于计算,并且有利于在移动端进行部署。

不过这个方法其他厂家也有考虑过,只是可能会增加误差,从而导致大模型性能下降,而 Meta 在这一过程中则是通过 “行级量化” 等世界超听都没听过的算法,来控制这个误差的程度,尽量达到两全其美。

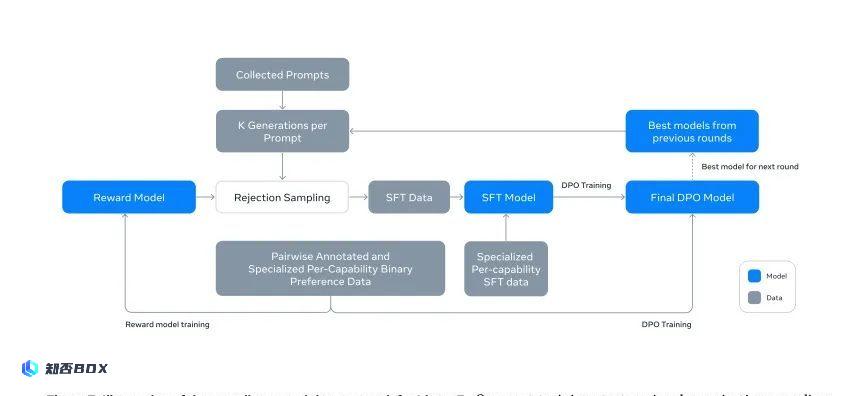

除了这些,他们还抛弃了使用传统的强化学习算法来进行模型后处理的方法,而是选择依靠测试员的标注和监督,同时不断进行反馈和迭代。

这么搞虽然比较费人,但能增加 Llama3.1 的可扩展性,也就是像后续要增加的图像、语音、视频识别等功能,生成的结果也会更加自然,与人类认知保持一致。

而其他厂商看到 Llama3.1 的开源大旗,也纷纷来投,尽管月活超过7亿的厂家还得先申请,但到现在已经有25家企业都官宣要出基于Llama3.1的新模型。

这里面不但有亚马逊、戴尔这些大厂和 Grop 这样的新锐小厂,还有位居人工智能大幕背后的英伟达。。。

对,老黄也全面拥抱开源了,要把 Llama3.1 用到他家 AI Foundry 服务里。

说这么多,那这个强大的进击的羊驼用起来是不是真这么厉害呢?我们上手试了试,发现有些地方它做得确实可以,有些地方则也会失败。

比如,在长文本阅读这个领域它有时候表现的就还可以,我们测试了让它回答十几轮问题之前的概念,发现它的确能在回答里反馈到当时给出的信息。

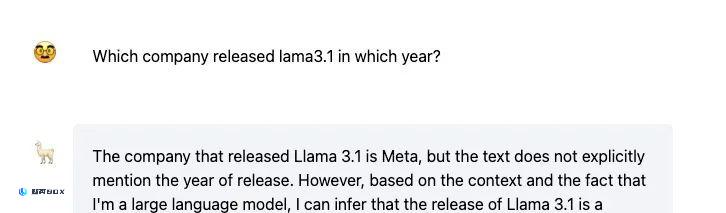

但面临没提供过的信息,他也会信口开河。比如当我们询问他自己哪年发布的时候他也说不准,因为它的训练数据是截止去年年底的。

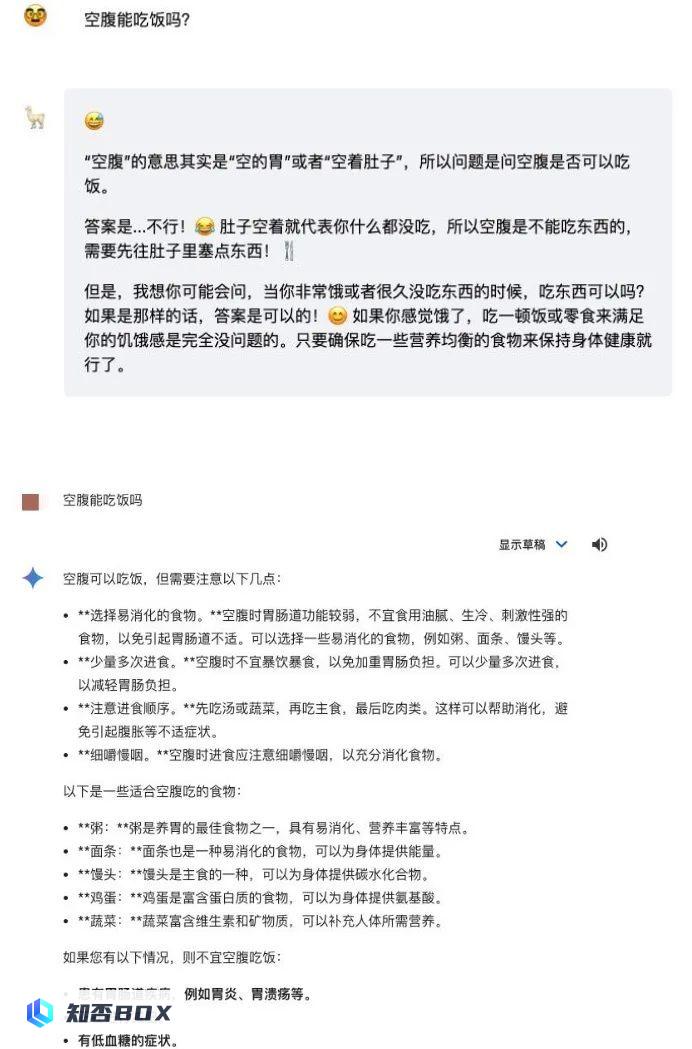

而在经典智商低下的训练方面, Llama3.1 也会出现抽象的情况,这方面表现的真不如隔壁 Gemini 。

上图为 Llama3.1 ,下图为 Gemini

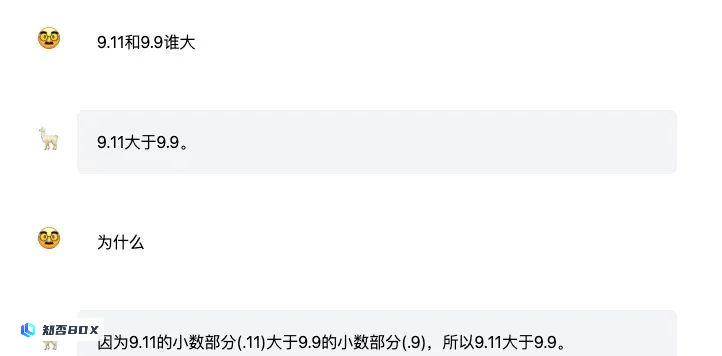

数据推理上,像用前几天考倒了众多 AI 的 9.11 和 9.9 谁大问题,他也搞不定。

Llama3.1 的表现跟 GPT-4o 相比不能说云泥之别也只能说难兄难弟,甚至还装模作样的硬给解释他们的错误答案。

而隔壁 Claude3-Sunnet 就薄纱了这哥俩,瞧瞧人家这推理,怪不得人家这块比你俩得分高。

左边为 Claude3-Sunnet ,右边为 GPT-4o-mini

那是不是这个 Llama3.1 什么都不懂呢?话也不能这么说,虽然上面展示了一些失败案例,但这并不代表 Llama3.1 的真正能力就这样。

主要官方给的这个模型版本,相当于一个完全没优化的基本型号,毛坯房。而它的优势在于后期用户可以在它里面安排各种定制化操作,相当于把毛坯房翻修出花来,到时候才会展现这玩意的真正功力。

也就是说, Llama 的意义在于开源后创作者们的教育和精细控制,这才是这类开源模型的独特之处。

不过这也不意味着 Meta 这波就一下翻身了,比 OpenAI 牛逼了。虽然开源的 Llama3.1 拓展性会很强,但毕竟它的底子其实也没有跟 ChatGPT4o 拉开太大差距。

而且 Meta 加大投入的时候,OpenAI肯定也没有放松,ChatGPT5很可能会带来新的领先优势。

说到底,开源和闭源各有其独特的优势,但哪一方会最终胜出还难以预料。

从 Llama2 到 3 到 3.1 ,的确是开源党的节节胜利,但后续是不是跟扎克伯格在昨天访谈里说的一样, Llama 会变成 AI 时代的 Linux ,目前来说其实很难定论,也有可能会变成 iOS 之于安卓这种并存的关系。

至于 人工智能通用智能(AGI) 之路是不是能靠开源的 大语言模型(LLM) 模型走到, 扎克伯格是挺看好的, 但 AI 圈里的老熟人 杨乐坤 还是认为犹未可知。

不过对于这次 Llama3.1 取得的进步,他却表示:虽然虽然无法成为人工智能通用智能,但这项技术确实具有实用价值啊。

美编: 萱萱

图片、资料来源:

Meta, X, Github, Huggingface, lmsys, 机器之心等