一项新的研究发现,人工智能(AI)或许具备了人类特有的能力之一,即“心智理论”(Theory of Mind,ToM)。

也就是说,在追踪人类的心理状态方面,比如“发现错误想法”“理解间接言语”“识别失礼”等,GPT(GPT-4、GPT-3.5)和 Llama 2 在特定情况下的表现,已被证明接近甚至超过了人类。

也就是说,在追踪人类的心理状态方面,比如“发现错误想法”“理解间接言语”“识别失礼”等,研究表明GPT(GPT-4、GPT-3.5)和 Llama 2 在特定情况下的表现,已经接近甚至超过了人类。

这些发现不仅表明大型语言模型(LLMs)展示出了与人类心理推理输出一致的行为,而且还强调了系统测试的重要性,以确保在人类智能和人工智能之间进行深入的比较。

相关研究论文以“Testing theory of mind in large language models and humans”为题,已发表在 Nature 子刊 Nature Human Behaviour 上。

相关研究论文题目为“在大型语言模型和人类中测试心智理论”,已经在《自然》子刊《自然人类行为》上发表。GPT 更懂“误导信息”,Llama 2 更懂“尊重他人的言辞”

心智理论,是一个心理学术语,是一种能够理解自己以及周围人类的心理状态的能力,这些心理状态包括情绪、信仰、意图、欲望、假装等,自闭症通常被认为是患者缺乏理解自己以及周围人类心理状态的能力所导致的。

以往,心智理论这一能力被认为是人类特有的。然而,现在人们开始认识到,除了人类之外,还有其他动物也可能具备类似的心智理论能力。这些动物包括黑猩猩、大象、海豚、马、猫、狗等。尽管目前仍存在争议,但有研究表明它们可能具备简单的心智理论能力。

最近,像ChatGPT这样的大型语言模型(LLMs)的快速发展引发了一场激烈的争论,即这些模型在心智理论任务中表现出的行为是否与人类行为一致。

在这项工作中,来自德国汉堡-埃彭多夫大学医学中心的研究团队及其合作者,反复测试了两个系列的语言模型(GPT 和 Llama 2)的不同心智理论能力,并将它们的表现与 1907 名人类参与者进行比较。

研究人员发现,GPT 模型在识别间接要求、错误想法和误导三个方面的表现非常出色,甚至超过了人类的平均水平。而相比之下,Llama 2 的表现则不如人类。

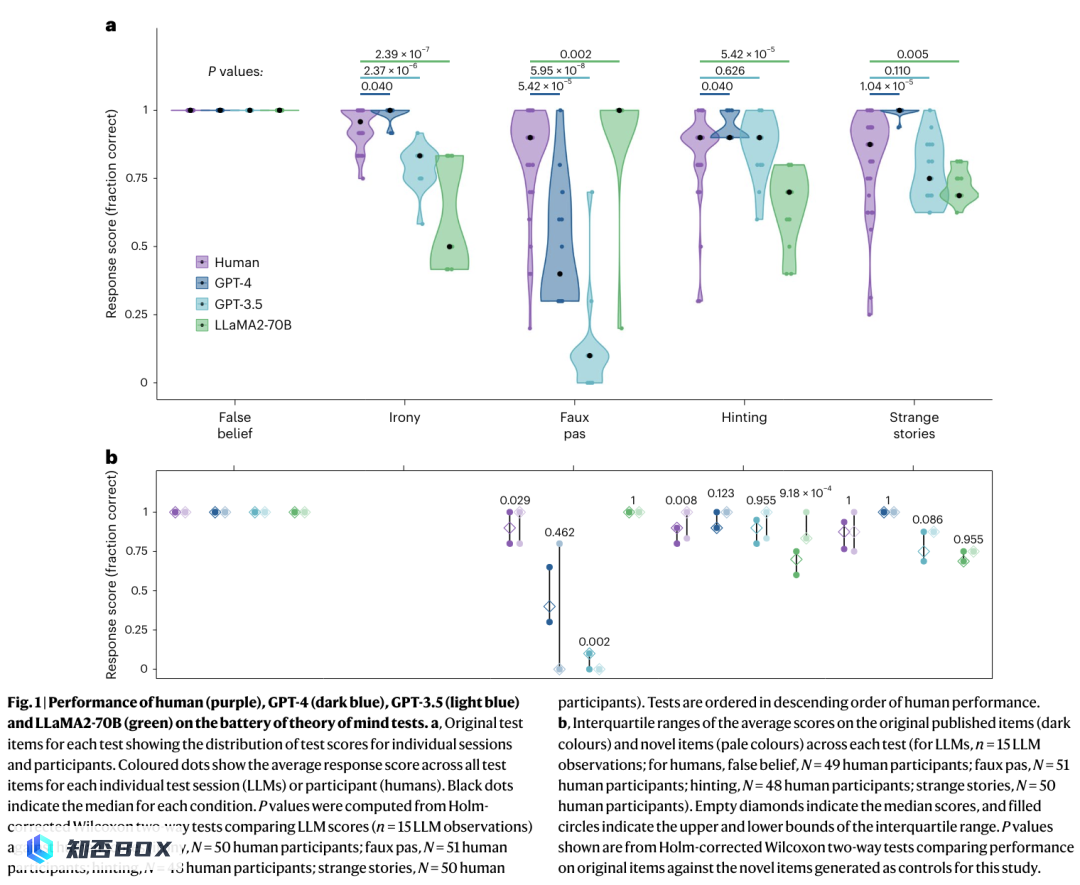

图|人类(紫色)、GPT-4(深蓝色)、GPT-3.5(浅蓝色)和LLaMA2-70B(绿色)在心智理论测试中的表现。

在识别失礼行为方面,Llama 2 比人类更擅长,但 GPT 的表现不太好。

研究团队认为,Llama 2 表现优秀的原因在于其回答中偏见程度较低,而非仅仅是对失礼行为敏感。而GPT的表现较差则是因为其过于保守地坚持结论,而非推理错误。

人工智能的心智理论已经达到了与人类相当的水平吗?

在论文的讨论部分,研究团队对GPT模型在识别不当言论任务中的表现进行了深入分析。实验结果显示,GPT模型在识别不当言论方面存在过度保守的假设,而不是推理能力差。当问题以可能性的形式提出时,GPT模型能够准确地识别并选择最可能的解释。

同时,研究人员还通过后续实验发现,LLaMA2-70B的优越性可能是由于它对未知情况的偏见,而不是真正的推理能力。

此外,研究人员还提出了未来研究的方向,包括进一步探索GPT模型在实时人机交互中的表现,以及这些模型的决策行为如何影响人类的社会认知。

他们提醒道,虽然LLM在心智理论任务上表现出与人类相当的水平,但这并不意味着它们具备与人类相同的能力,也不代表它们能够完全掌握心智理论。

尽管如此,他们也表示,这些结果是未来研究的重要基础,并建议进一步研究低水平语言模型(LLM)在心理推断上的表现会如何影响个体在人机交互中的认知。