【新智元导读】I/O大会上,谷歌Gemini 1.5 Pro一系列更新让开发者们再次沸腾。最新技术报告中,最引人注目的一点是,数学专业版1.5 Pro性能碾压GPT-4 Turbo、Claude3 Opus,成为全球最强的数学模型。

经过四个月的迭代,Gemini 1.5 Pro已经成为了全球最强大的LLM(几乎)。

谷歌I/O发布会上,劈柴宣布了Gemini 1.5 Pro一系列升级,包括支持更长的上下文长度,达到200k,并且能够处理超过35种语言。

与此同时,新成员Gemini 1.5 Flash推出,设计体积更小,运行速度更快,还支持100k上下文。

最近,Gemini 1.5 Pro最新版的技术报告新鲜出炉了。

论文地址:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

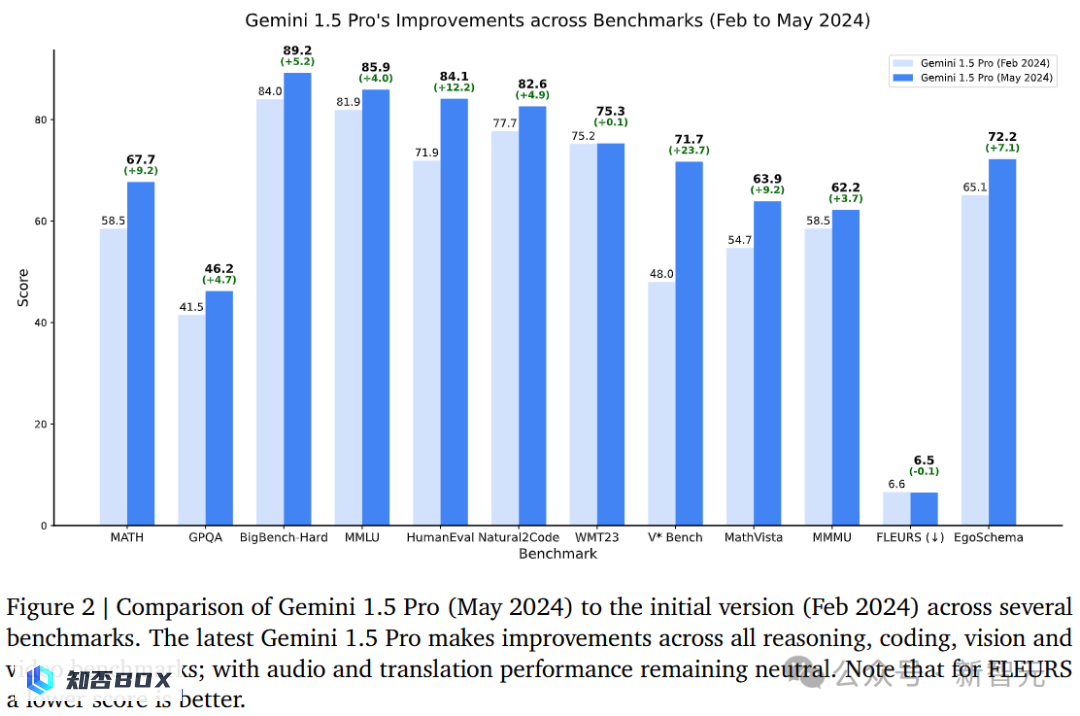

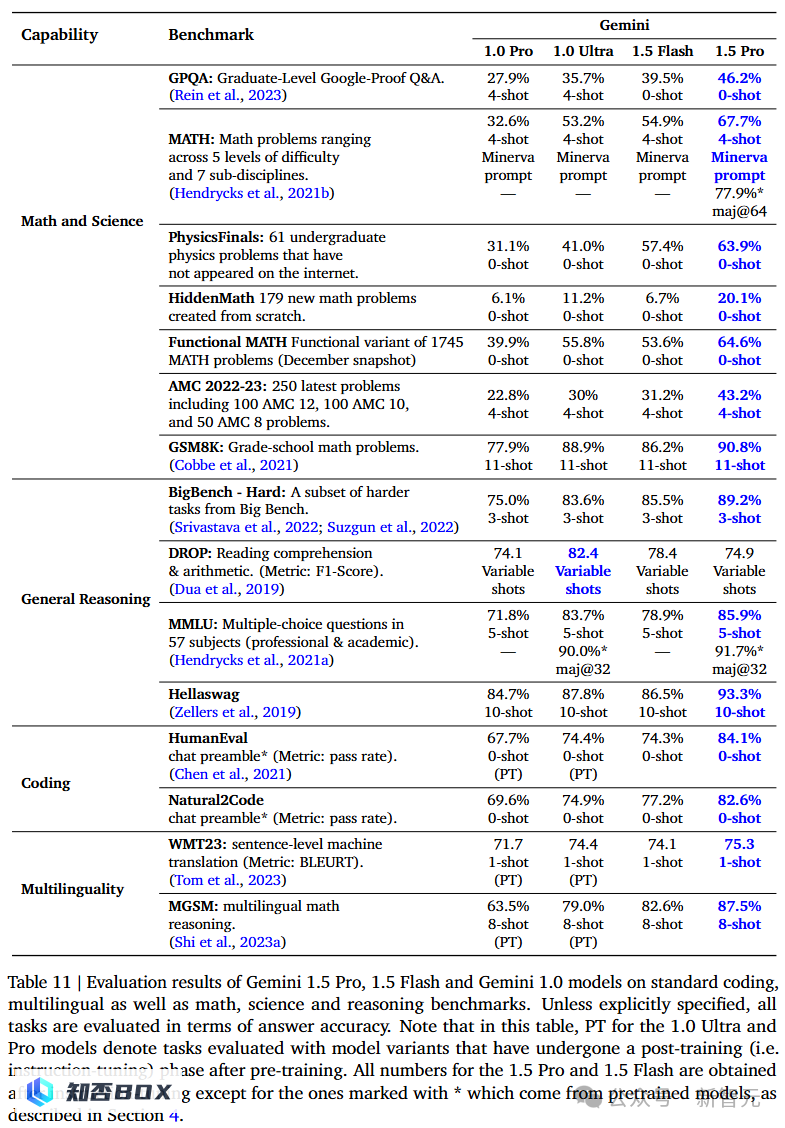

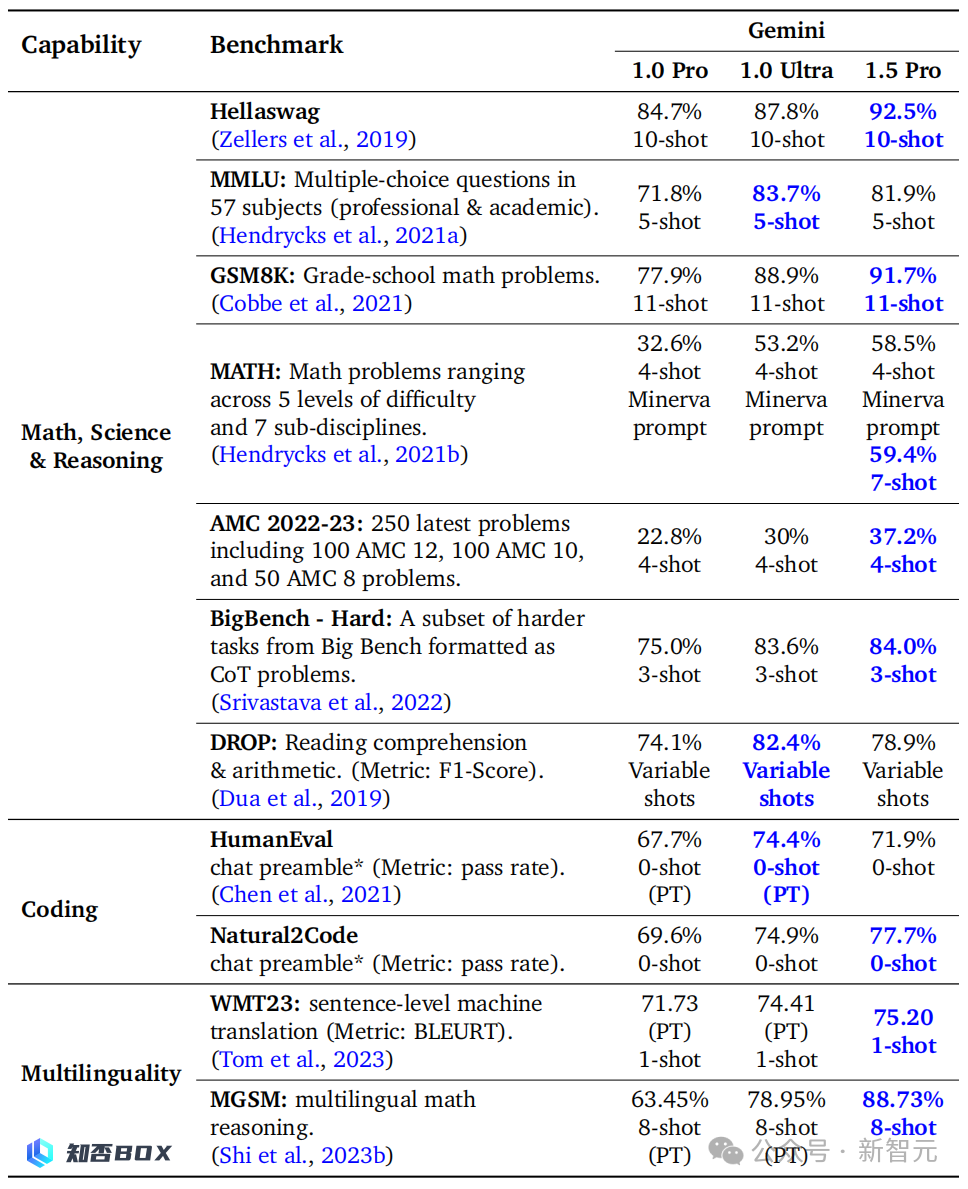

报告显示,经过升级的Gemini 1.5 Pro模型在所有关键基准测试中都取得了显著的进步。

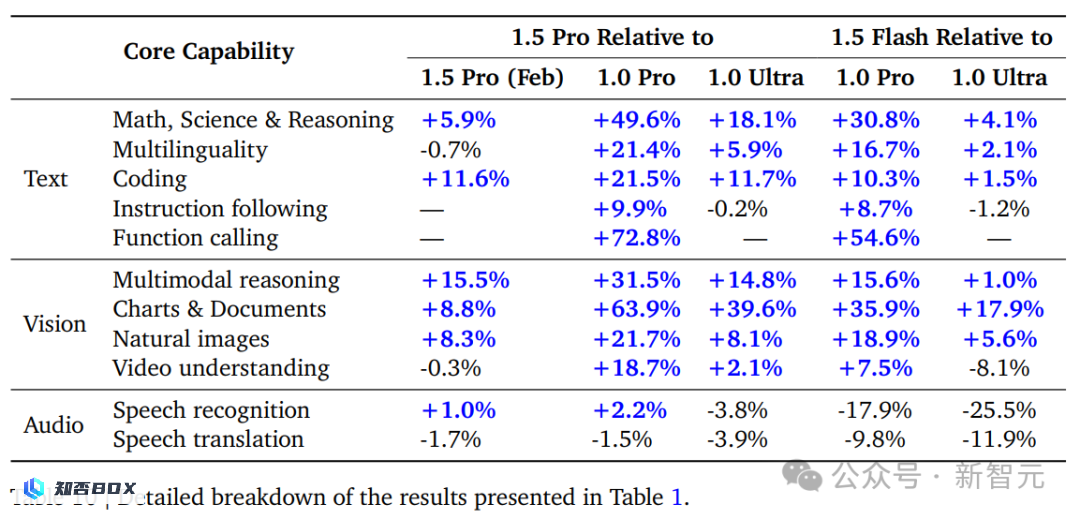

简单来说,1.5 Pro的性能超过了「超大杯」1.0 Ultra,而1.5 Flash(最快的模型)的性能接近于1.0 Ultra。

甚至,新的Gemini 1.5 Pro和Gemini 1.5 Flash在大多数文本和视觉测试中,其性能还超过了GPT-4 Turbo。

Jeff Dean发文称,Gemini 1.5 Pro「数学定制版」在基准测试中,取得了创纪录的91.1%的高分。

而三年前的今天,SOTA(State of the Art)仅为6.9%。

此外,数学专业版的 Gemini 1.5 Pro在数学基准测试中的表现与人类专家相当出色。

数学评测在过去三年内大幅增长了84.2%

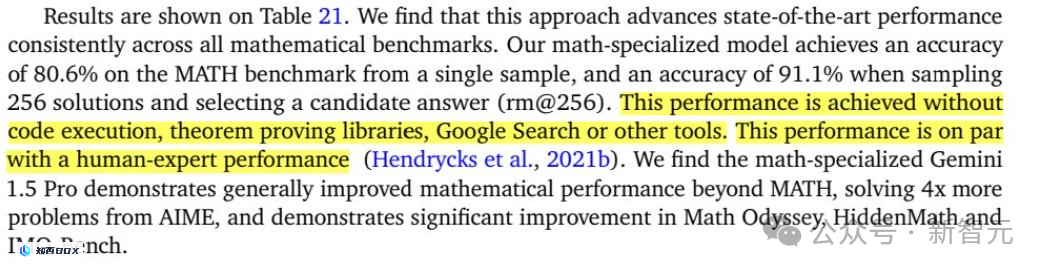

对于这个「数学定制版」模型,团队使用了多个由数学竞赛衍生的基准测试评估Gemini的能力,包括MATH(数学竞赛)、AIME(美国初级数学考试)、Math Odyssey(数学奥德赛)和团队内部开发的测试HidemMath、IMO-Bench等。

根据测试结果显示,Gemini 1.5 Pro「数学定制版」在所有测试中表现出明显的优势,相比于Claude 3 Opus和GPT-4 Turbo,它有着显著的改进。此外,与通用版本的1.5 Pro相比,Gemini 1.5 Pro「数学定制版」也有着显著的改进。

特别是在MATH测试中,我取得了91.1%的突破性成绩。这个成绩非常令人振奋,因为我没有使用任何定理证明库或者谷歌搜索等外部工具。这意味着我在数学方面的能力已经达到了与人类专家相当的水平。

此外,在AIME测试集中,Gemini 1.5 Pro「数学定制版」能够解决的问题数量是其他模型的四倍。

以下是两道曾让之前的模型无法解决的亚太数学奥林匹克竞赛(APMO)题。

其中,上面的这个例子很有代表性,因为它是一道证明题,而不是简单的计算题。

对此,Gemini给出的解法不仅直接攻击要害,而且非常巧妙。

Gemini 1.5 Pro核心性能全面提升,为用户带来更出色的使用体验。

文本评估

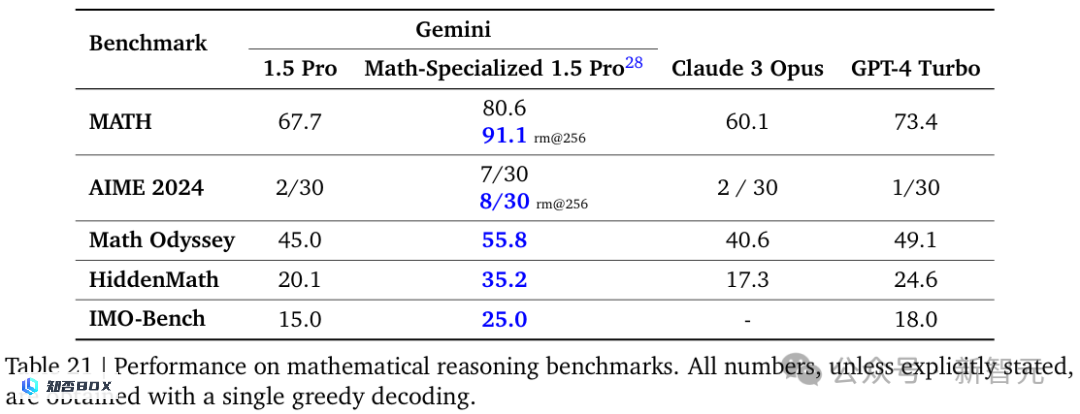

除了数学之外,升级后的1.5 Pro在推理、编码、多模态多项基准测试中,取得了明显的优势。

甚至就连主打输出速度的1.5 Flash,在性能上也不输1.0 Ultra。

尤其是,在MMLU通用语言理解基准测试中,Gemini 1.5 Pro在正常的5个样本设置中得分为85.9%,在多数投票设置中得分为91.7%,超过了GPT-4 Turbo。

尤其值得注意的是,在MMLU通用语言理解基准测试中,Gemini 1.5 Pro在正常的5个样本设置中取得了85.9%的得分,在多数投票设置中更是高达91.7%的得分,这一成绩超过了GPT-4 Turbo。

与2月出版的技术报告进行对比,新升级的1.5 Pro在代码两项基准中取得了显著的提升。在HumanEval测试中,提升了12.2个百分点,从71.9%增长到84.1%。在Natural2Code测试中,提升了4.9个百分点,从77.7%增长到82.6%。

在多语种基准测试中,新升级1.5 Pro的性能稍微降低。

此外,5月报告中,将数学和推理能力分开评测,在数学基准上,新升级1.5 Pro的得分有所下降,从91.7%下降到90.8%。

在推理测试中,MMLU上的性能从81.9%提升到85.9%。

2月份的版本

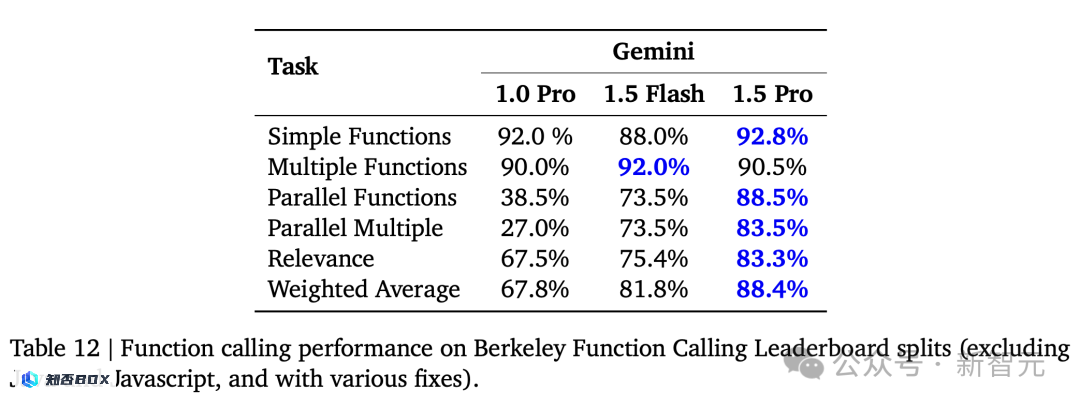

针对函数调用,1.5 Pro在多项任务中,除了多项函数,都取得了最高分。1.5 Flash在多项函数任务中,取得了领先优势。

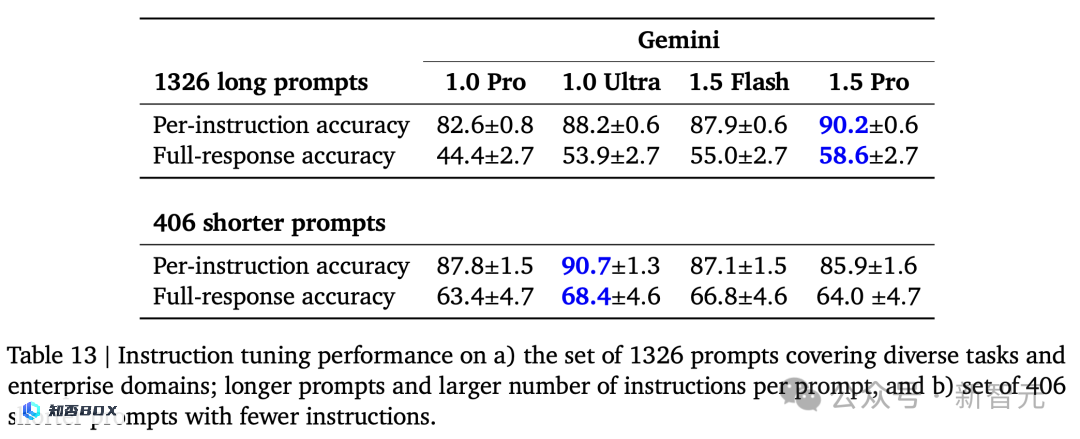

在指令调优上,当面对更长指令1326提示时,1.5 Pro的回应准确率最高。而对于更短的指令406,1.0 Ultra的表现更为优秀。

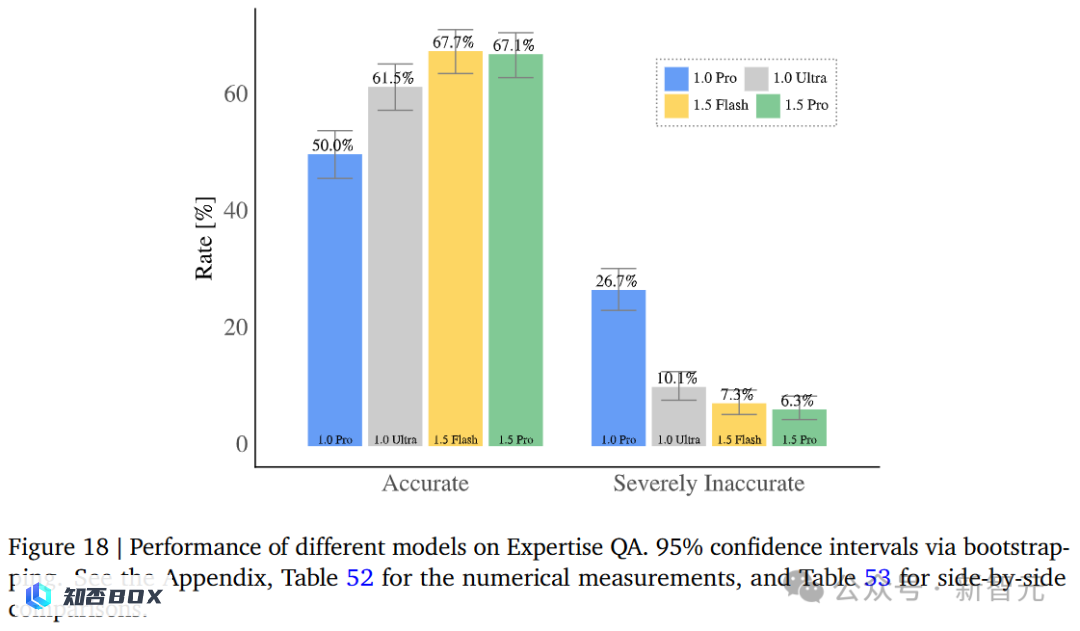

涉及到更专业的知识问答时,1.5 Pro的准确率几乎与1.5 Flah持平,仅相差0.6%,但都明显优于1.0 Pro和1.0 Ultra。

针对STEM上下文问答任务中,在Qasper数据集上,Gemini 1.0和1.5的准确率有所提高,但与此同时不准确率明显降低。

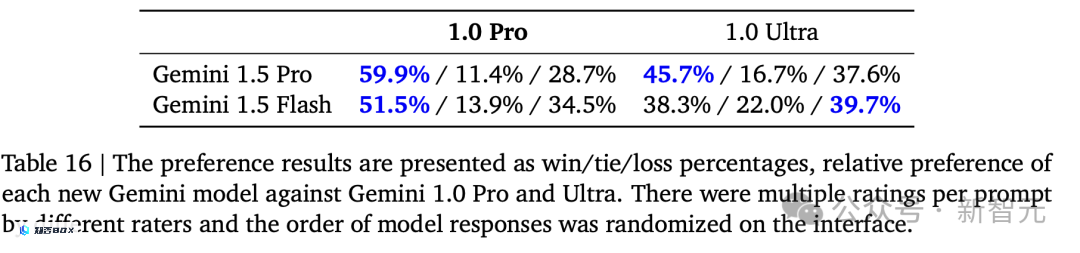

再来看偏好结果,针对不同提示,与1.0 Pro比起来,1.5 Pro和1.5 Flash相对得分更高。

再来看偏好结果,针对不同提示,与1.0 Pro版本相比,1.5 Pro版本和1.5 Flash版本的得分相对较高。

多模态评估

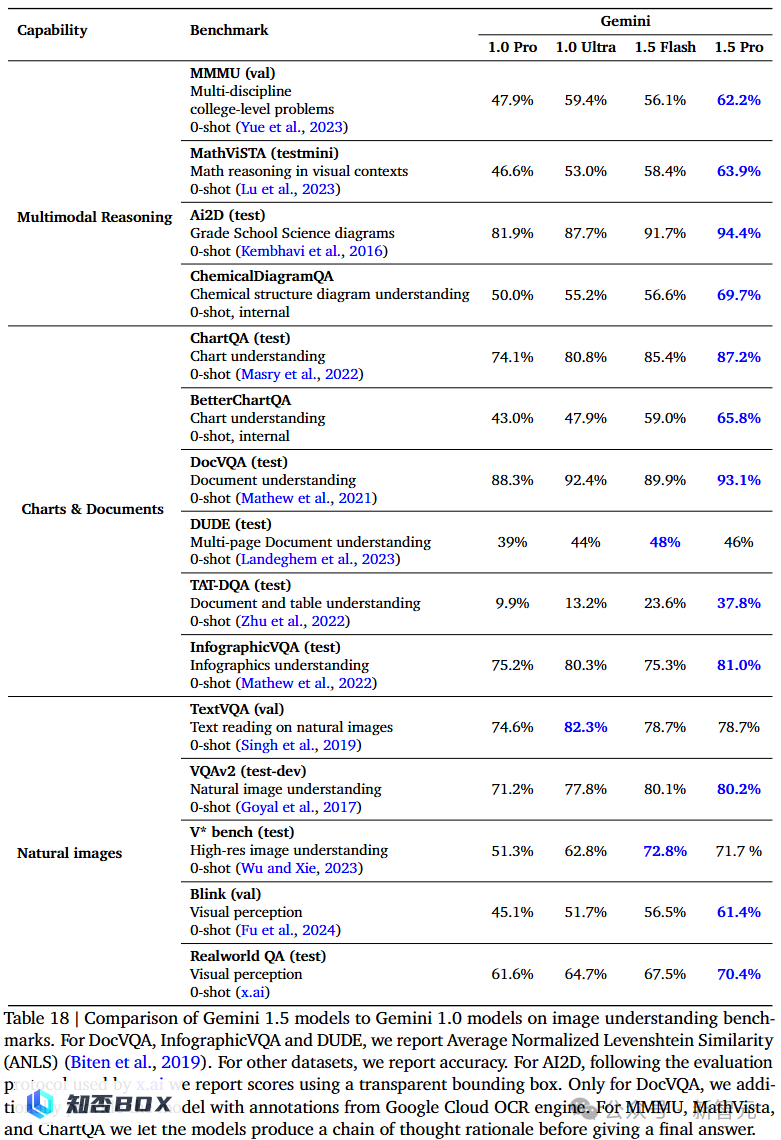

针对多模态性能,技术报告中涉及了众多基准测试,包括多模态推理、图表与文档、自然图像以及视频理解四个方面,共涵盖了15个图像理解任务和6个视频理解任务。

总体来看,除了一项测试之外,1.5 Pro的表现均能超过或者与1.0 Ultra相当,且轻量的1.5 Flash在几乎所有测试中都超过了1.0 Pro。

总体来看,除了一项测试之外,1.5 Pro的性能在大部分情况下都能超过或者与1.0 Ultra相当,而且轻量级的1.5 Flash在几乎所有测试中都表现出了超过1.0 Pro的优势。

可以看到1.5 Pro在多模态推理的4个基准测试上都有所提高。

在公认较为困难的MMMU(多模态多目标优化)测试中,1.5 Pro版本实现了从47.9%提升到62.2%的显著提高。在研究生水平的Ai2D(人工智能二维图像)测试上,1.5 Pro版本甚至达到了94.4%的高分。而1.5 Flash版本也取得了91.7%的优异成绩。

对于多模态大模型,包括图表和文档在内的各种信息的理解是相当具有挑战性的,因为需要对图像信息进行准确的解析和推理。

Gemini 1.5 Pro在ChartQA任务中取得了87.2%的最先进结果(State-of-the-Art,SOTA)。

在TAT-DQA测试上,分数从1.0 Pro的9.9%升至37.8%,1.5 Flash相比1.0 Ultra也有将近10%的提高。

在TAT-DQA测试中,1.0 Pro的分数从9.9%提升至37.8%,显示出了显著的进步。同时,1.5 Flash相比1.0 Ultra也有近10%的提高,进一步证明了其性能的优越性。

此外,团队创建了BetterQA等9个互不相交的能力测试。结果显示,相比上一代的1.0 Pro,1.5 Pro总体达到了20%以上的提升。

此外,团队还开发了其他9个独立的能力测试,如BetterQA等。根据测试结果显示,与上一代的1.0 Pro相比,1.5 Pro在整体上提升了20%以上的水平。

自然图像理解方面的测试,主要关注模型对现实世界的理解和空间推理能力。

在专门的V*测试中,1.5 Pro和测试提出者所发表的模型SEAL几乎表现相当。

在人类擅长而模型不擅长的Blink测试中,1.5 Pro实现了从45.1%(1.0 Pro)到61.4%的提升,Flash分数相近(56.5%),依旧高于1.0 Ultra(51.7%)。

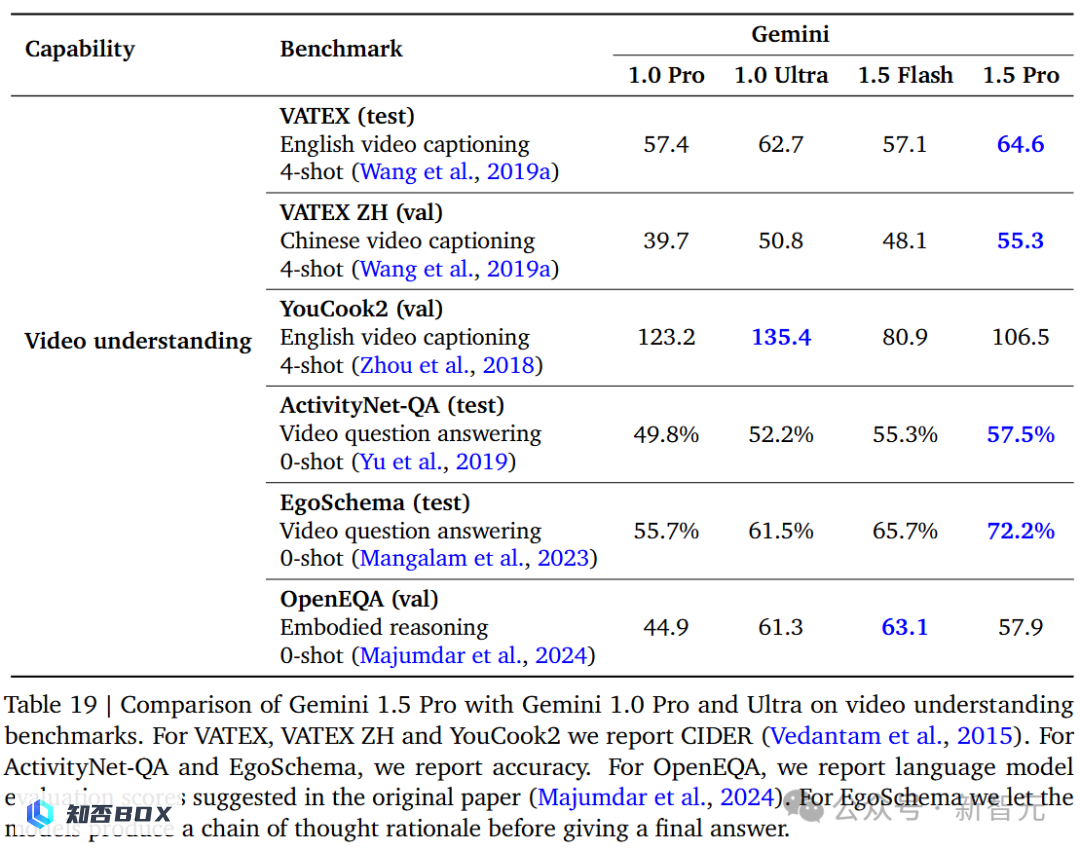

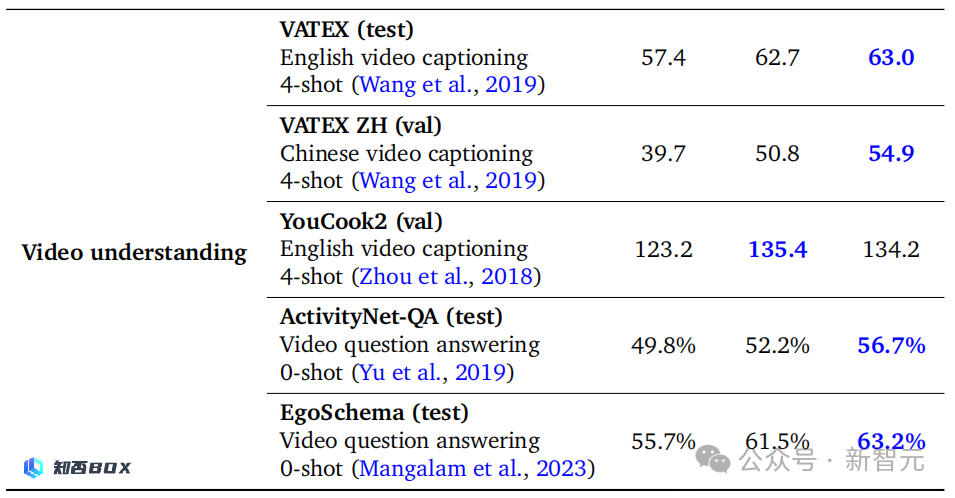

除了「大海捞针」之外,团队还对Gemini 1.5 Pro进行了其他视频理解方面的基准测试,但是相比前三个方面,提升并不明显。

在VATEX英文和中文的两个测试中,与2月份发布的Gemini 1.5 Pro的技术报告进行对比后发现,经过三个月的训练,性能提升不超过2分。

在YouCook2测试中,1.5 Pro似乎始终不能达到1.0 Ultra的135.4分,而且相比2月技术报告中的134.2下降到了最新的106.5。

有趣的是,在OpenEQA的零样本测试上,1.5 Flash得分63.1,甚至超过了1.5 Pro的57.9。技术报告中解释,这是由于1.5 Pro拒绝回答某些问题造成的。

2月份的版本

对比GPT-4和Claude3,GPT-4具有明显的优势。

接下来,再看看横向对比,新升级的1.5 Pro与GPT-4、Claude模型相较下的性能如何。

改进模型的诊断能力

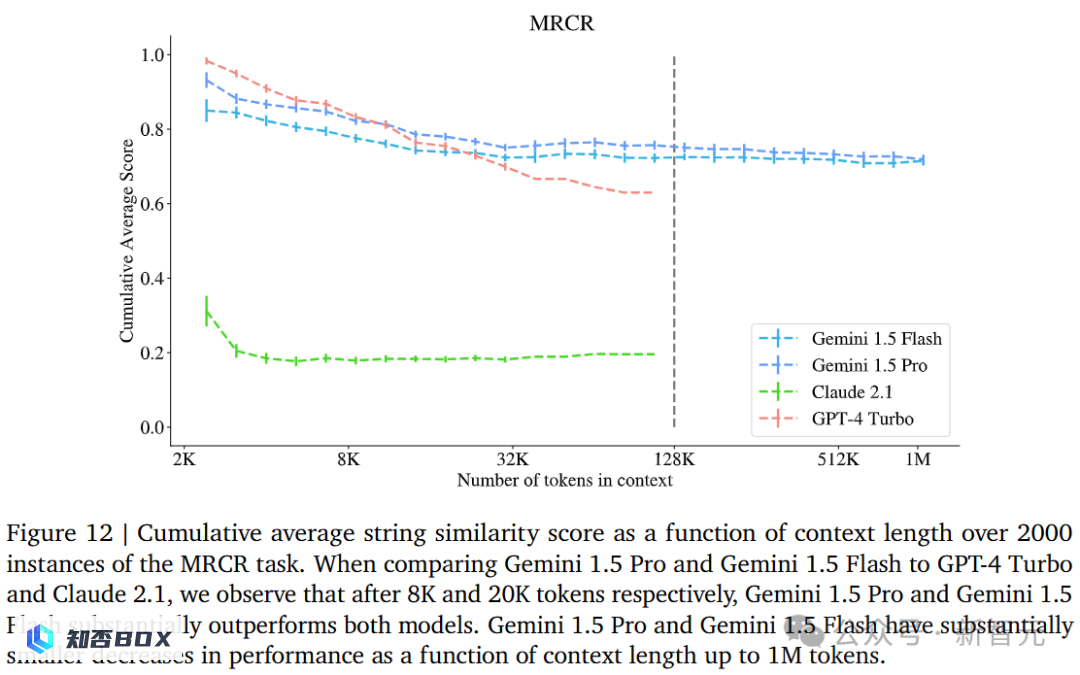

如下展示的是,在2000个MRCR(Machine Reading Comprehension and Reasoning)任务实例中,字符串相似度累积平均得分与上下文长度的函数关系。

在与GPT-4 Turbo和Claude2.1进行比较时,研究人员发现,经过分别使用8K和20K个词组进行测试后,1.5 Pro和1.5 Flash的性能明显超过了这两个模型。

随着上下文长度的增加,1.5 Pro和1.5 Flash的性能下降幅度大大缩小,最高可达100万个token。

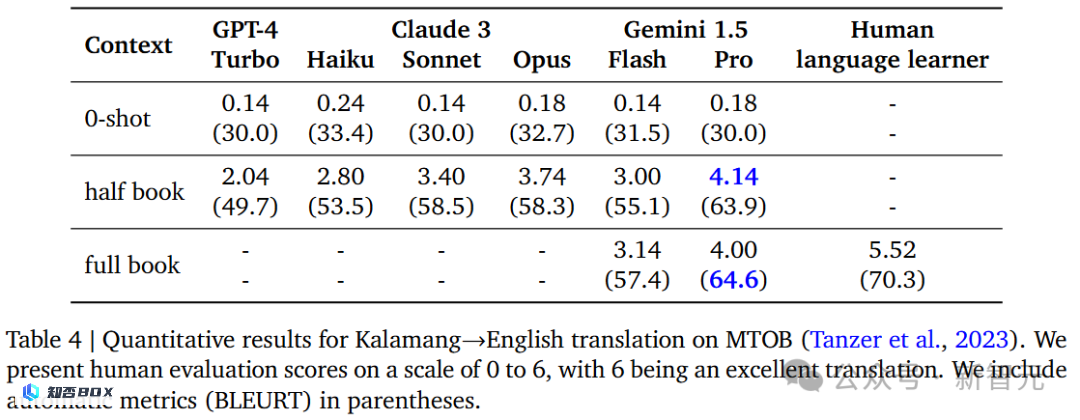

在将小语种Kalamang翻译成英语的量化结果如下所示。

根据测试结果显示,经过升级的1.5 Pro在输入了大量数据(包括半本书或者全本书)后,其性能得到了显著提升,并且超过了GPT-4 Turbo和Claude3的表现。

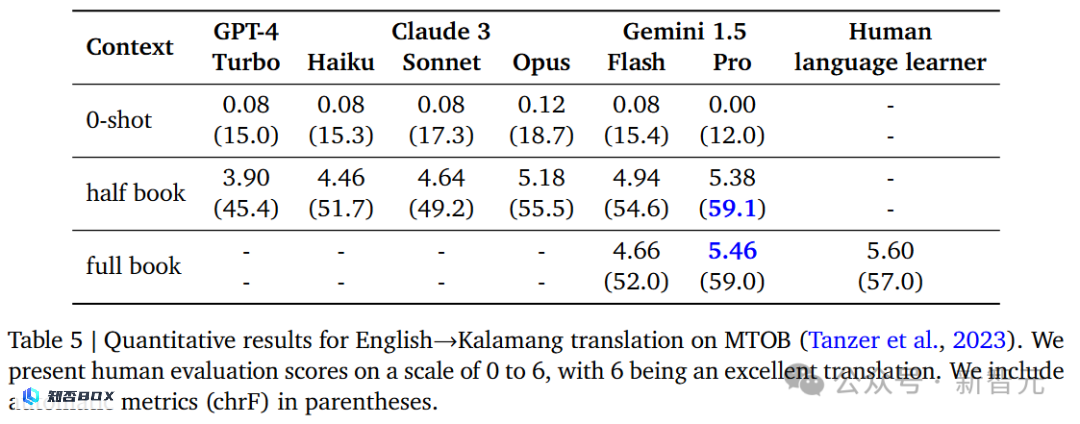

而在将英语翻译成Kalamang语言的量化结果中,1.5 Pro的胜率也是最高的。

低资源机器翻译的长上下文扩展

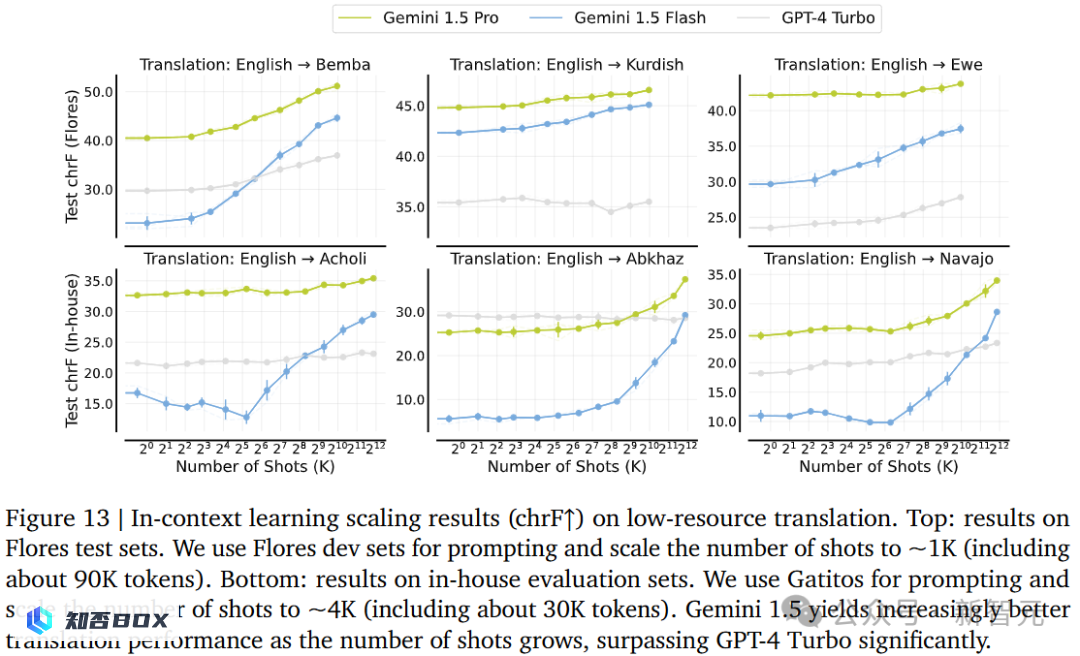

再来看,在「低资源」机器翻译中,模型的上下文学习扩展(Scaling)表现出了很好的效果。

随着样本数量的不断增加,1.5 Pro的翻译性能逐渐提升,显著超过了GPT-4 Turbo。

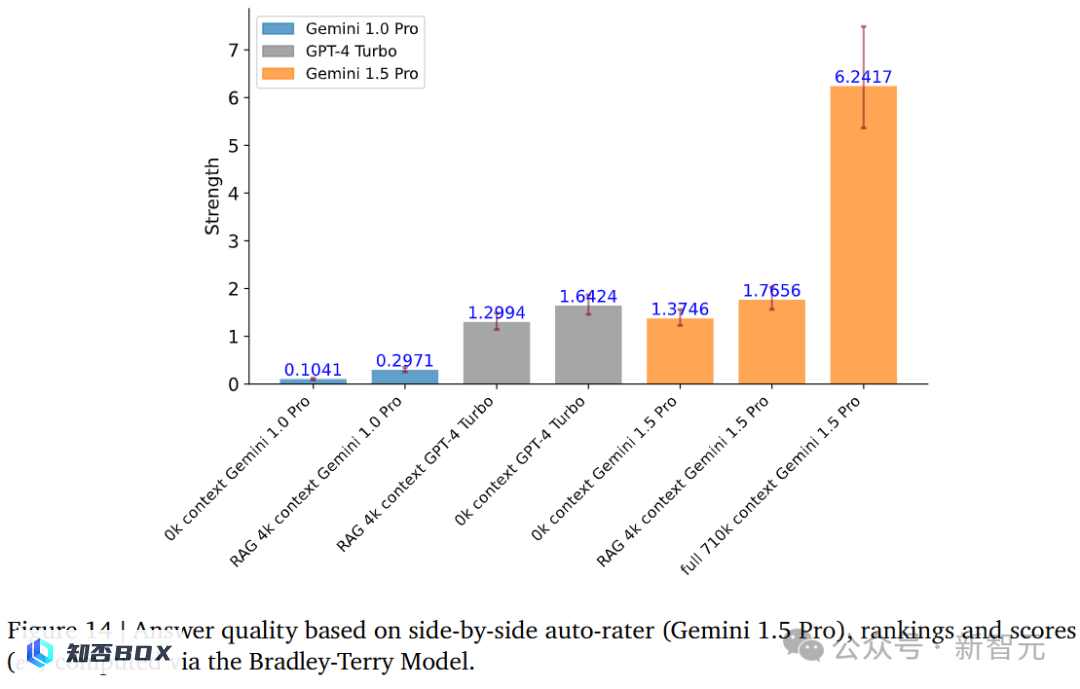

长上下文文本问答

针对长文本的问答,1.5 Pro在710k左右的上下文中,表现明显优于GPT-4Turbo。并且,超过了没有上下文的情况,以及在RAG模型的支持下,能够处理4k左右的上下文的1.5 Pro。

长上下文音频

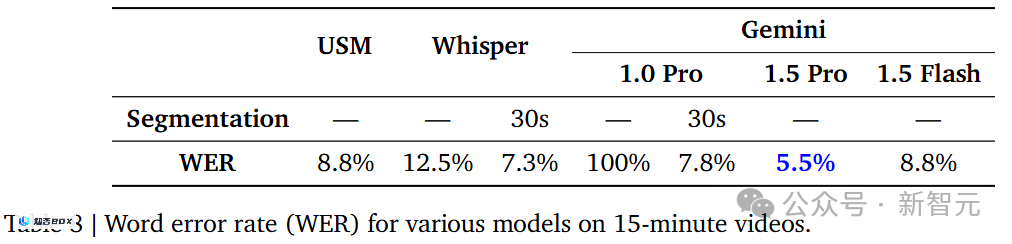

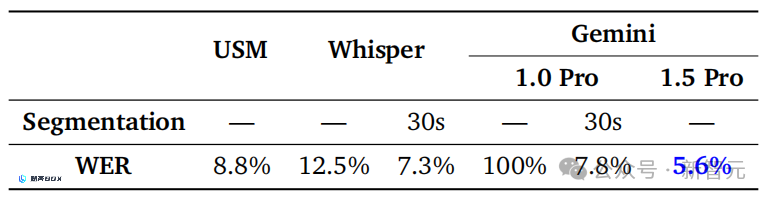

在音频长上下文的测试中,每个模型的单词错误率表现如何?

可以看到,1.5 Pro仅有5.5%的错误率,而OpenAI的Whisper模型的错误率高达12.5%。

但与

2月份的版本

的报告相比,1.5 Pro的音频长下文单词错误率还是有所下降。

2月份的版本

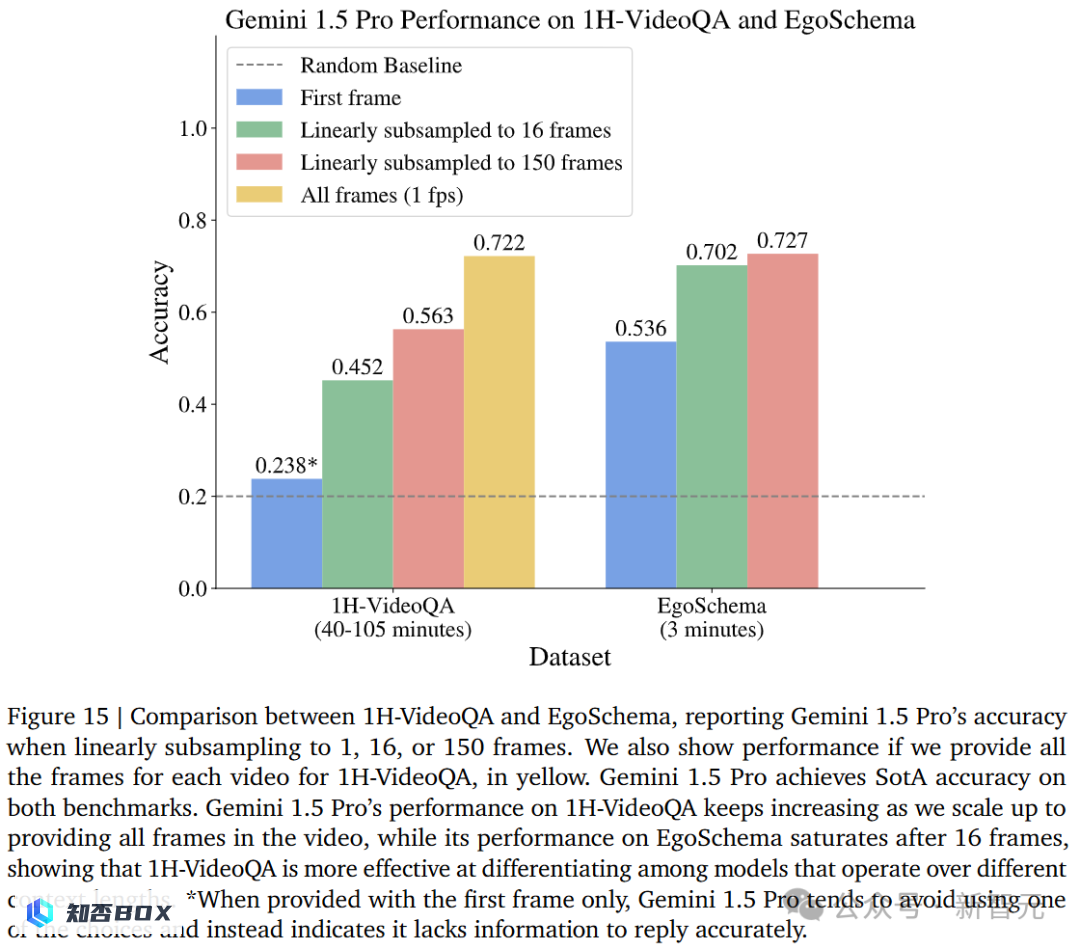

长上下文视频问答

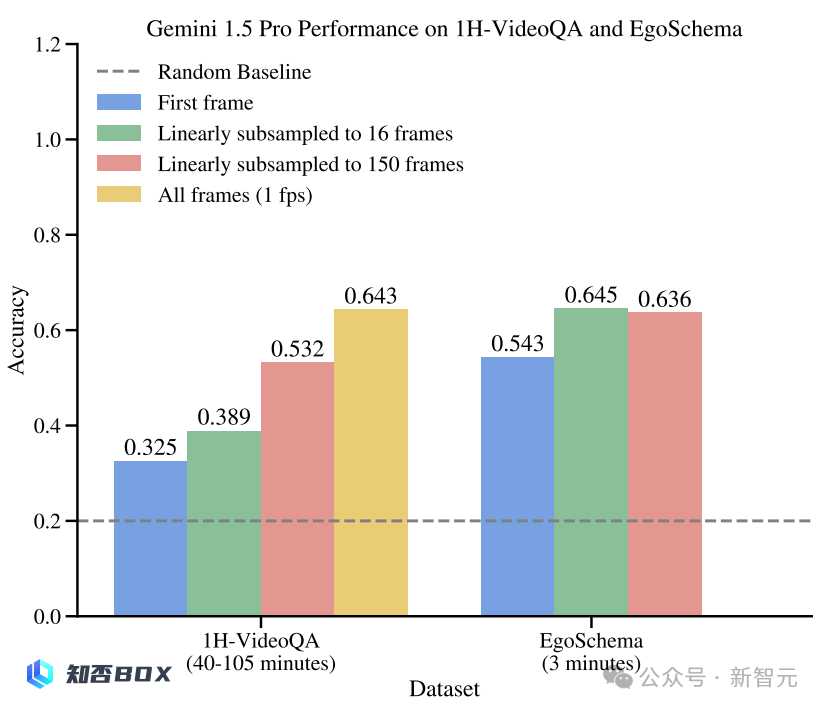

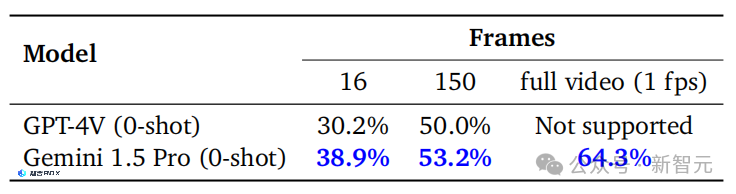

针对1个小时的视频问答任务,1.5 Pro在不同基准上的准确率与3分钟视频任务的准确率基本持平一致。

再来看去年

2月份的版本

的对比,1.5 Pro在1小时任务中的准确率有了很大提升,从最高0.643上涨到0.722。还有在3分钟视频QA任务中,从0.636上涨到0.727。

2月份的版本

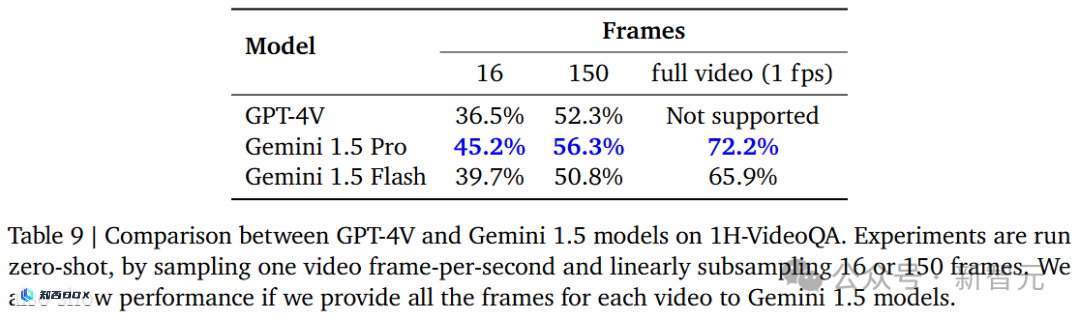

在1H-VideoQA测试中,团队在时长1小时的视频中每秒取1帧画面,最终线性下采样至16帧或150帧,分别输入给GPT-4V与Gemini 1.5进行问答。

在1H-VideoQA测试中,团队通过从时长为1小时的视频中每秒提取1帧画面的方式,对视频进行采样。最终,他们将采样结果进行线性下采样,得到了16帧或150帧的画面。这些画面分别被输入给GPT-4V和Gemini 1.5进行问答。

无论帧数多少,Gemini 1.5 Pro的性能都比GPT-4V更好,尤其在16帧测试中,优势最为明显(36.5% vs. 45.2%)。

在观看整个视频后进行回答时,Gemini 1.5 Pro的正确率从2月的64.3%提升至72.2%。

2月份的版本

长期规划和战略规划

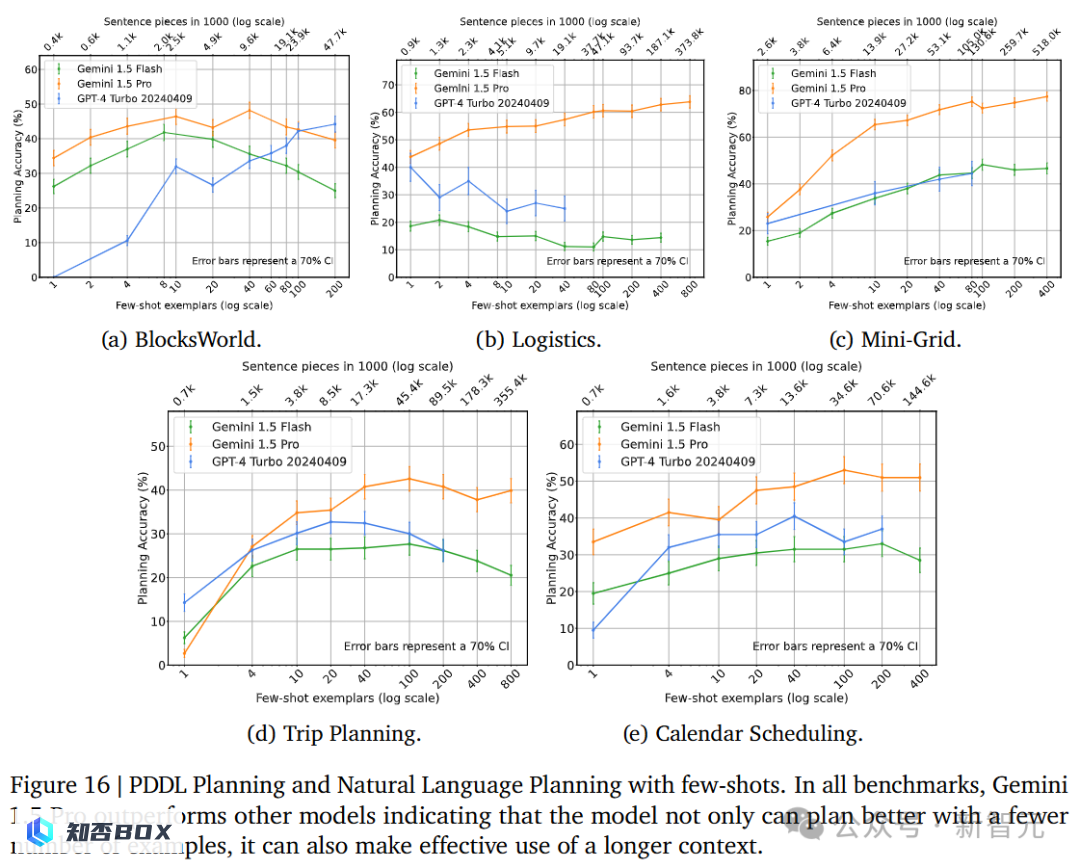

「推理」和「规划」技能对解决问题都非常关键,尽管LLM在推理方面取得了显著进展,但在规划方面仍然面临很大的困难。

这篇报告详细介绍了Gemini 1.5版本的规划能力测试。测试内容包括移动积木、安排物流路线、室内导航、规划日程和旅行路线等多个任务场景。

测试中,模型必须根据给定任务,一次性地迅速生成解决方案,类似于人类的「头脑风暴」过程。

总体上,Gemini 1.5 Pro在大多数情况下的表现优于GPT 4 Turbo,不仅能在少样本时较好进行规划,还能更有效地利用额外的上下文信息。

尽管Gemini 1.5 Flash的性能不如Gemini 1.5 Pro,但在近一半的情况下,它可以与GPT-4 Turbo的性能相媲美。

GPT-4Turbo在BlocksWorld中的零样本表现非常差,几乎没有取得任何成绩,而Gemini 1.5 Pro和Flash分别取得了35%和26%的成绩。

对于日历调度来说,GPT的1-shot准确率低于10%,而1.5 Pro的准确率达到33%。

随着样本数量逐渐增多,1.5 Pro的表现逐渐变得更好,但GPT-4 Turbo在样本增加到一定程度时会出现下降趋势,在Logistics中甚至持续下降。

比如在Calendar Scheduling中,当样本数量逐渐增加至80-shot时,GPT-4 Turbo和1.5 Flash的准确率只有38%,比Gemini 1.5 Pro低了32%。

之后增加至400-shot时,1.5 Pro模型达到了77%的准确率,而GPT模型的准确率仍然停留在50%左右。

非结构化多模态数据分析任务

在现实世界中,许多数据,如图像和对话,仍然保持着非结构化的形式。

研究人员向LLM展示了一组1024张图像,旨在将图像中的信息提取到结构化数据表中。

图17展示了从图像中提取不同类型信息的准确性结果的详细情况。

Gemini 1.5 Pro在所有属性提取方面的准确性提高了9%(相对于之前的数值)。同时,与GPT-4Turbo相比,1.5 Pro的提升幅度达到了27%。

然而,在评估时,由于技术限制,Claude 3 API无法分析超过20张图像,因此Claude 3 Opus的结果受到了限制。

此外,研究结果显示,1.5 Pro型号在处理更多图像时表现出持续更好的结果。这表明该型号能够有效地利用额外的上下文信息和更长的上下文长度。

而对于GPT-4 Turbo来说,随着提供的图像数量增加,其准确性反而降低