在多模态工具盛行的时代,大核卷积神经网络再次崭露头角,成为了一匹新的黑马。

腾讯人工智能实验室与港中文联合团队提出了一种新的卷积神经网络架构,图像识别准确度和处理速度都超过了转换器架构模型。

切换到点云、音频、视频等其他模态,也无需改变模型结构,简单预处理即可达到甚至超越目前最先进的水平。

团队提出了专门用于设计大型卷积神经网络(CNN)架构的四条准则和一种名为UniRepLKNet的强大的主干网络。

只要使用ImageNet-22K进行预训练,模型的准确度和速度都能达到最先进水平(SOTA)。

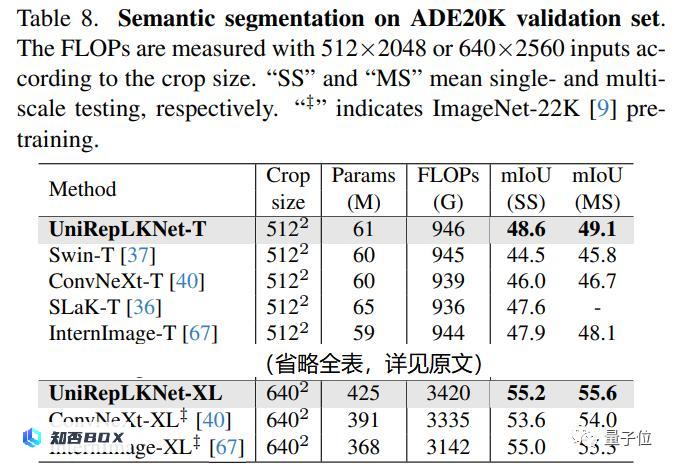

ImageNet的准确率达到了88%,COCO的盒子平均精度达到了56.4%,ADE20K的平均交并比达到了55.6%,在实际测速中具有明显的优势。

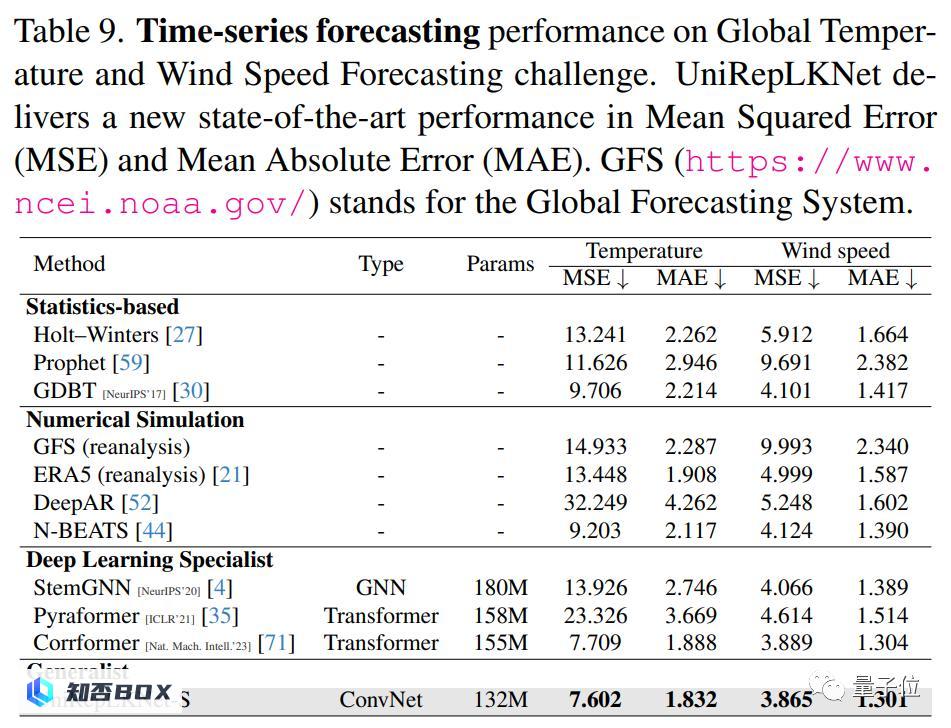

在时序预测的大规模数据上使用UniRepLKNet,也能达到最佳水平——

例如在全球气温和风速预测方面,它的性能超过了Nature子刊上基于Transformer的最先进技术。

进一步了解,请继续阅读作者的投稿。

为什么在“Transformer时代”仍然需要使用CNN

在开始介绍UniRepLKNet的原理之前,作者首先回答了两个问题。

首先,我们需要明确一个事实,即Transformer模型在自然语言处理领域取得了巨大的成功。然而,尽管Transformer在处理序列数据方面表现出色,但在处理图像数据方面,它并不是最优选择。

在图像处理领域,卷积神经网络(CNN)是一种非常强大的模型。CNN通过局部感知和权值共享的方式,能够有效地捕捉图像中的空间特征。这使得CNN在图像分类、目标检测和图像生成等任务上表现出色。

此外,CNN还具有计算效率高的优点。由于卷积操作的局部性质,CNN在处理图像时可以并行计算,从而加快了模型的训练和推理速度。

因此,尽管Transformer在自然语言处理领域取得了巨大的成功,但在图像处理领域,CNN仍然是一种不可忽视的模型。研究CNN可以帮助我们更好地理解图像处理的特点,并为图像相关任务的解决方案提供更多选择。

作者认为,Transformer和CNN只是两种结构设计思路相互融合的方式,没有理由认为前者在本质上更优越。

“Transformer的目标是统一各个模态”,这正是研究团队试图修正的认知。

就在2022年初,ConvNeXt、RepLKNet和其他一些工作问世之前,“Transformer在图像任务上表现出色,超越了CNN”成为主流观点。

这些结果的出现后,人们开始认识到“CNN和Transformer在图像任务上表现相似”。

本研究团队的成果将其进一步改进:在点云、音频、视频上,卷积神经网络比我们预期的更强大。

在时序预测这个领域,尽管CNN并不是传统的强项(LSTM等曾经是主流,最近两年Transformer越来越受欢迎),但CNN仍然能够超越Transformer,并成功地应用于该领域。

因此,研究团队认为,卷积神经网络(CNN)在实现统一性方面可能与变压器(Transformer)不相上下。

另一个问题是,如何将一个专为图像任务设计的卷积神经网络(CNN)应用于音频、视频、点云和时序数据?

为了保持简洁和通用性,当将UniRepLKNet应用于其他模态时,不会对模型架构主体进行任何修改(以下实验使用的都是UniRepLKNet-Small)。

只需要将视频、音频、点云、时序数据处理成C×H×W的嵌入图(对于图像来说,C=3),就能实现到其他模态的过渡,例如:

对于时序数据,可以参考CorrFormer中的嵌入层,将数据转换为隐空间中的张量,然后将其简单地重塑为一幅单通道图像。

后续的展示将证明,这样简单的设计会产生出非常出色的效果。

卷积神经网络(CNN)的架构设计

2022年,RepLKNet提出了使用更大的卷积核(从13×13到31×31)来构建现代CNN以及正确使用更大卷积核的几个设计原则。

然而,从架构角度来看,RepLKNet只是简单地采用了Swin Transformer的整体架构,并没有进行任何修改。

目前,大型卷积神经网络(CNN)的架构设计要么遵循现有的CNN设计原则,要么遵循现有的Transformer设计原则。

在传统的卷积网络架构设计中,当研究者向网络中添加一个3×3或5×5卷积层时,通常希望它能够同时实现以下三个目标:

扩大视野

提升抽象程度,比如从线条到纹理,再从纹理到物体的细节

通过增加深度来提高表征能力,即增加层数、参数数量和非线性程度,可以提高模型的拟合能力。

那么,设计大卷积核CNN架构时,应该遵循哪些原则呢?

本文强调,应该将上述三种要素解耦,根据需要选择相应的结构来实现:

通过使用较少的大卷积核来实现更广阔的感受野。

通过使用3×3的depthwise卷积来增强特征抽象的层次。

使用一些高效的结构(例如SE Block、Bottleneck structure等)来增加模型的深度,从而提升其整体的表示能力。

这种解耦之所以能够实现,正是大卷积核的本质优势所保证的,即不依赖于深度堆叠的大感受野。

经过系统研究,本文提出了设计大卷积核CNN的四个架构指导原则。

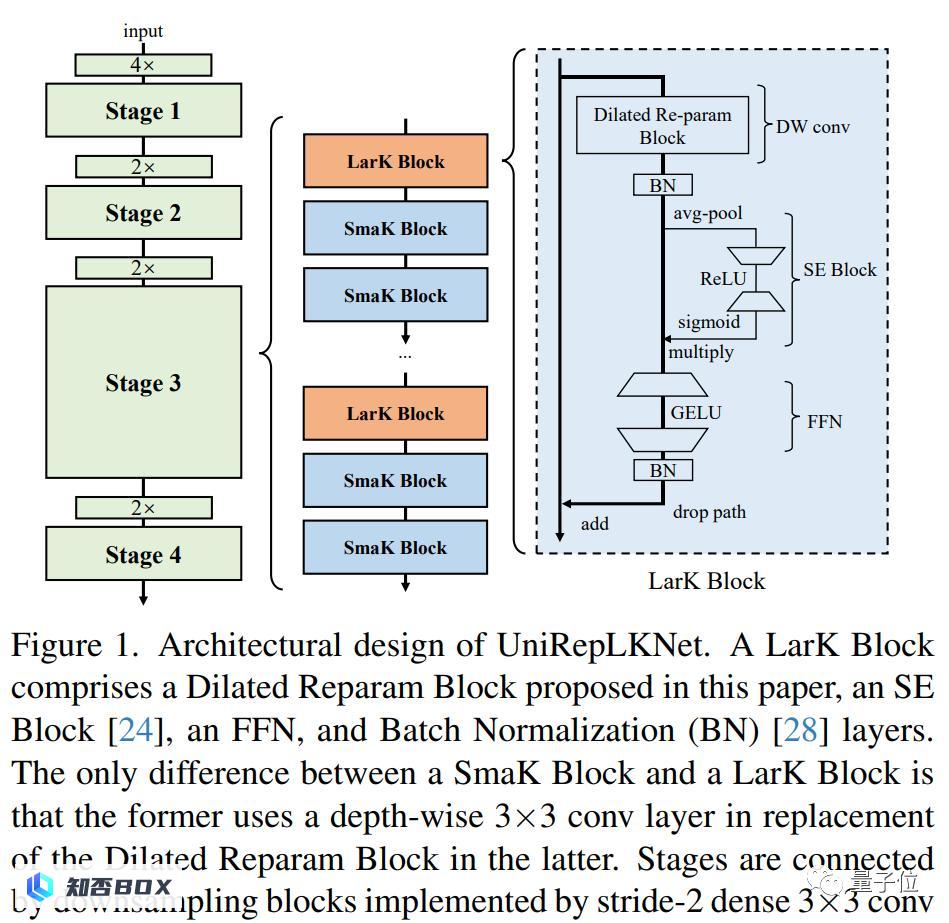

根据这些指导方针,本文提出的UniRepLKNet模型结构如下:

其中depthwise conv可以是大卷积核(图中所示的Dilated Reparam Block,其使用膨胀卷积来辅助大核卷积来捕捉稀疏的特征而且可以通过结构重参数化方法等价转换为一个卷积层),也可以只是depthwise 3×3。

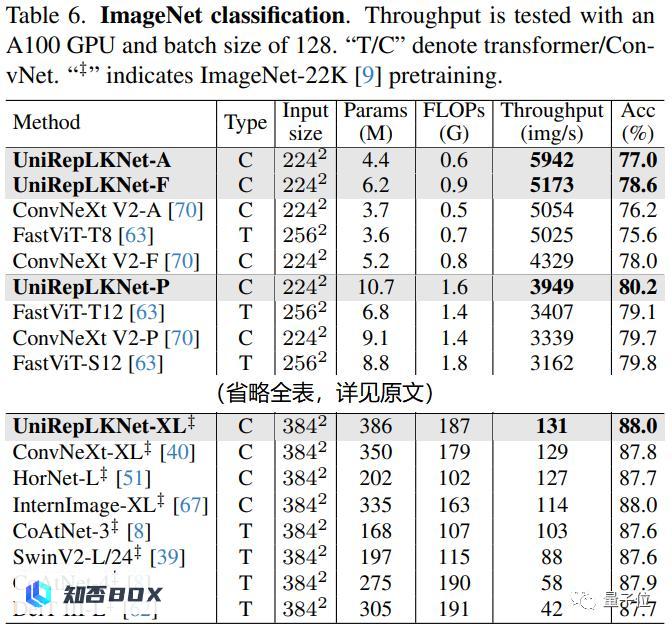

多种表现超越变形金刚

作为图像模态中的重要数据集,ImageNet、COCO和ADE20K的结果是必不可少的。论文中只使用了ImageNet-22K进行预训练,并没有使用更大的数据集。

尽管大核CNN一开始并没有特别重视ImageNet(因为图像分类任务对表征能力和感受野的要求不高,无法充分发挥大kernel的潜力),但UniRepLKNet仍然超过了最新的许多模型,在实际测速中表现出色。

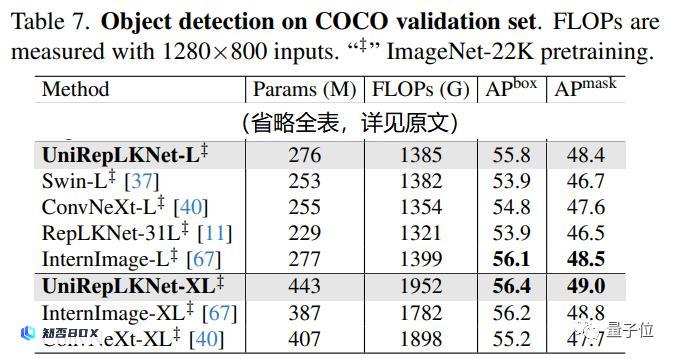

在COCO目标检测任务中,UniRepLKNet的主要竞争对手是InternImage:

在COCO数据集上,UniRepLKNet-L的性能不如InternImage-L,但是UniRepLKNet-XL的性能超过了InternImage-XL。

考虑到InternImage团队在目标检测领域的专业经验非常丰富,这一成果也算非常难得。

在ADE20K语义分割任务中,UniRepLKNet表现出了明显的优势,其最高mIoU达到了55.6。与ConvNeXt-XL相比,UniRepLKNet的性能超出了整整1.6个百分点。

为了测试UniRepLKNet在处理时序数据方面的能力,本文选择了一个规模庞大的任务,即全球气温和风速的预测。

虽然UniRepLKNet最初是为图像任务设计的,但它能够超越CorrFormer(前SOTA)在这个任务上的表现。

这一发现尤为有趣,因为这种超大规模时间序列预测任务听起来更适合LSTM、GNN和Transformer,这次CNN却将其“抢先一步”了。

在音频、视频和点云任务上,本文的简化处理方法同样非常有效。

还有一件事

除了提出一种在图像上非常强大的主干网络之外,本文所报告的这些发现似乎表明,大型卷积神经网络的潜力还没有得到完全发掘。

即使在Transformer的理论优势——”全面建模能力”方面,大核CNN也比我们所想象的更加强大。

本文还提供了相关证据:将卷积核大小从13减小到11后,这四个模态的性能都明显下降。

此外,作者已经公开了所有代码,并将所有模型和实验脚本开源。

论文链接:

请点击这里查看相关内容。