AIGC动态欢迎阅读

原标题:如何让等变神经网络可解释性更强?试试将它分解成「简单表示

」

关键字:神经网络,表示,线性,解读,周期性文章来源:机器之心

内容字数:0字内容摘要:

机器之心报道

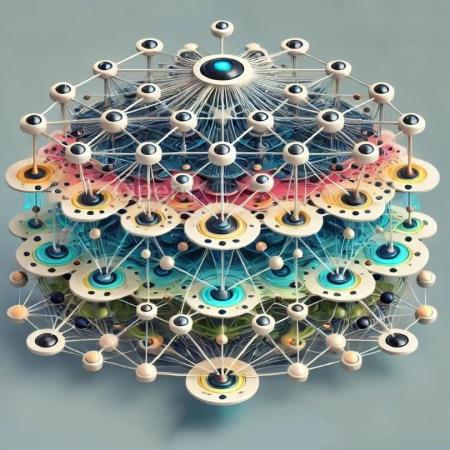

编辑:Panda神经网络是一种灵活且强大的函数近似方法。而许多应用都需要学习一个相对于某种对称性不变或等变的函数。图像识别便是一个典型示例 —— 当图像发生平移时,情况不会发生变化。等变神经网络(equivariant neural network)可为学习这些不变或等变函数提供一个灵活的框架。

而要研究等变神经网络,可使用表示论(representation theory)这种数学工具。(请注意,「表示」这一数学概念不同于机器学习领域中的「表征」的典型含义。本论文仅使用该术语的数学意义。)

近日,Joel Gibson、Daniel Tubbenhauer 和 Geordie Williamson 三位研究者对等变神经网络进行了探索,并研究了分段线性表示论在其中的作用。论文标题:Equivariant neural networks and piecewise linear representation theory

论文地址:https://arxiv.org/pdf/2408.00949

在表示论中,简单表示(simple representation)是指该理论的原文链接:如何让等变神经网络可解释性更强?试试将它分解成「简单表示」

联系作者

文章来源:机器之心

作者微信:

作者简介: